Lean 4 定理证明

作者:Jeremy Avigad, Leonardo de Moura, Soonho Kong and Sebastian Ullrich, 以及Lean社区 译者 subfish_zhou

本中文教程旨在教你使用Lean 4。 参考Lean 4 Manual中的Setting Up Lean section一节来安装Lean。本项目也包括一个快速安装教程。 本书的Lean 2 和Lean 3 版本见这里。

本项目的翻译量较大,因此大多采用机翻,仅供习惯中文的读者作为参考,译者推荐有能力的读者阅读原文。欢迎对本译文提出宝贵意见,可邮件至subfishzhou@gmail.com 译者自制的习题参考答案在本项目Github仓库的Exercise文件夹中。本项目尚未完工。

介绍

计算机和定理证明

形式验证(Formal verification)是指使用逻辑和计算方法来验证用精确的数学术语表达的命题。这包括普通的数学定理,以及硬件或软件、网络协议、机械和混合系统中的形式命题。在实践中,验证数学命题和验证系统的正确性之间很类似:形式验证用数学术语描述硬件和软件系统,在此基础上验证其命题的正确性,这就像定理证明的过程。相反,一个数学定理的证明可能需要冗长的计算,在这种情况下,验证定理的真实性需要验证计算过程是否出错。

二十世纪的逻辑学发展表明,绝大多数传统证明方法可以化为若干基础系统中的一小套公理和规则。有了这种简化,计算机能以两种方式帮助建立命题:1)它可以帮助寻找一个证明,2)可以帮助验证一个所谓的证明是正确的。

自动定理证明(Automated theorem proving)着眼于 "寻找" 证明。归结(Resolution)定理证明器、表格法(tableau)定理证明器、快速可满足性求解器(fast satisfiability solvers)等提供了在命题逻辑和一阶逻辑中验证公式有效性的方法;还有些系统为特定的语言和问题提供搜索和决策程序,例如整数或实数上的线性或非线性表达式;像SMT(satisfiability modulo theories)这样的架构将通用的搜索方法与特定领域的程序相结合;计算机代数系统和专门的数学软件包提供了进行数学计算或寻找数学对象的手段,这些系统中的计算也可以被看作是一种证明,而这些系统也可以帮助建立数学命题。

自动推理系统努力追求能力和效率,但往往牺牲稳定性。这样的系统可能会有bug,而且很难保证它们所提供的结果是正确的。相比之下,交互式定理证明器侧重于 "验证" 证明,要求每个命题都有合适的公理基础的证明来支持。这就设定了非常高的标准:每一条推理规则和每一步计算都必须通过求助于先前的定义和定理来证明,一直到基本公理和规则。事实上,大多数这样的系统提供了精心设计的 "证明对象",可以传给其他系统并独立检查。构建这样的证明通常需要用户更多的输入和交互,但它可以让你获得更深入、更复杂的证明。

Lean 定理证明器旨在融合交互式和自动定理证明,它将自动化工具和方法置于一个支持用户交互和构建完整公理化证明的框架中。它的目标是支持数学推理和复杂系统的推理,并验证这两个领域的命题。

Lean的底层逻辑有一个计算的解释,与此同时Lean可以被视为一种编程语言。更重要的是,它可以被看作是一个编写具有精确语义的程序的系统,以及对程序所表示的计算功能进行推理。Lean中也有机制使它能够作为它自己的元编程语言,这意味着你可以使用Lean本身实现自动化和扩展Lean的功能。Lean的这些方面将在本教程的配套教程Lean 4编程中进行探讨,本书只介绍计算方面。

关于Lean

Lean 项目由微软雷德蒙德研究院的Leonardo de Moura在2013年发起,这是个长期项目,自动化方法的潜力会在未来逐步被挖掘。Lean是在Apache 2.0 license下发布的,这是一个允许他人自由使用和扩展代码和数学库的许可性开源许可证。

通常有两种办法来运行Lean。第一个是网页版本:由Javascript编写,包含标准定义和定理库,编辑器会下载到你的浏览器上运行。这是个方便快捷的办法。

第二种是本地版本:本地版本远快于网页版本,并且非常灵活。Visual Studio Code和Emacs扩展模块给编写和调试证明提供了有力支撑,因此更适合正式使用。源代码和安装方法见https://github.com/leanprover/lean4/.

本教程介绍的是Lean的当前版本:Lean 4。

关于本书

本书的目的是教你在Lean中编写和验证证明,并且不太需要针对Lean的基础知识。首先,你将学习Lean所基于的逻辑系统,它是依值类型论(dependent type theory)的一个版本,足以证明几乎所有传统的数学定理,并且有足够的表达能力自然地表示数学定理。更具体地说,Lean是基于具有归纳类型(inductive type)的构造演算(Calculus of Construction)系统的类型论版本。Lean不仅可以定义数学对象和表达依值类型论的数学断言,而且还可以作为一种语言来编写证明。

由于完全深入细节的公理证明十分复杂,定理证明的难点在于让计算机尽可能多地填补证明细节。你将通过依值类型论语言来学习各种方法实现自动证明,例如项重写,以及Lean中的项和表达式的自动简化方法。同样,繁饰(elaboration)和类型推理(type inference)的方法,可以用来支持灵活的代数推理。

最后,你会学到Lean的一些特性,包括与系统交流的语言,和Lean提供的对复杂理论和数据的管理机制。

在本书中你会见到类似下面这样的代码:

theorem and_commutative (p q : Prop) : p ∧ q → q ∧ p :=

fun hpq : p ∧ q =>

have hp : p := And.left hpq

have hq : q := And.right hpq

show q ∧ p from And.intro hq hp

你可以在Lean在线编辑器中尝试运行这些代码。(译者注:该编辑器速度很慢,且目前只支持Lean 3,但足够运行本书中大多数代码,仅需微小的语法改动。)

致谢

This tutorial is an open access project maintained on Github. Many people have contributed to the effort, providing corrections, suggestions, examples, and text. We are grateful to Ulrik Buchholz, Kevin Buzzard, Mario Carneiro, Nathan Carter, Eduardo Cavazos, Amine Chaieb, Joe Corneli, William DeMeo, Marcus Klaas de Vries, Ben Dyer, Gabriel Ebner, Anthony Hart, Simon Hudon, Sean Leather, Assia Mahboubi, Gihan Marasingha, Patrick Massot, Christopher John Mazey, Sebastian Ullrich, Floris van Doorn, Daniel Velleman, Théo Zimmerman, Paul Chisholm, and Chris Lovett for their contributions. Please see lean prover and lean community for an up to date list of our amazing contributors.

kokic、Faputa修改了n处typo,rujia liu审校了译本,toaster对改进译本提出了诸多宝贵建议,译者在此表示感谢。

安装Lean

(updates in 2023.09.17)

本教程演示在Windows系统下如何安装Lean 4正式版。Linux和MacOS版本请参考Lean Manual。

如果你身在中国,在运行安装程序前需要做如下准备:

在系统目录C:\Windows\System32\drivers\etc文件夹下找到hosts文件。对于其它系统用户也都是找到各自系统的hosts文件。

这个文件需要管理员权限来修改,有一个简便方法是,把它复制到别的地方修改,然后再粘贴回去,并选择使用管理员身份继续。

用记事本打开这个文件,在最后一行写入

185.199.108.133 raw.githubusercontent.com重启电脑,然后开启科学上网。(注意,你需要让终端也处在梯子的作用域中,例如你使用clash类梯子需要打开全局模式。)

(经过这个步骤之后你也可以使用官网提供的方法来安装了。)

如果你遇到"SSL connect error", "Timeout was reached","Failed to connect to github.com port 443"...等错误,就是说明你的网络环境有问题。重启电脑或者检查你的梯子。

基本安装

所有受支持平台的发布版本都可以在https://github.com/leanprover/lean4/releases中找到。

-

使用Lean版本管理器elan代替下载文件和手动设置路径。

在elan的Github仓库中下载最新release(对于windows,请下载elan-x86_64-pc-windows-msvc.zip),解压运行elan-init.exe,按照指示安装。

默认安装位置是用户文件目录下的

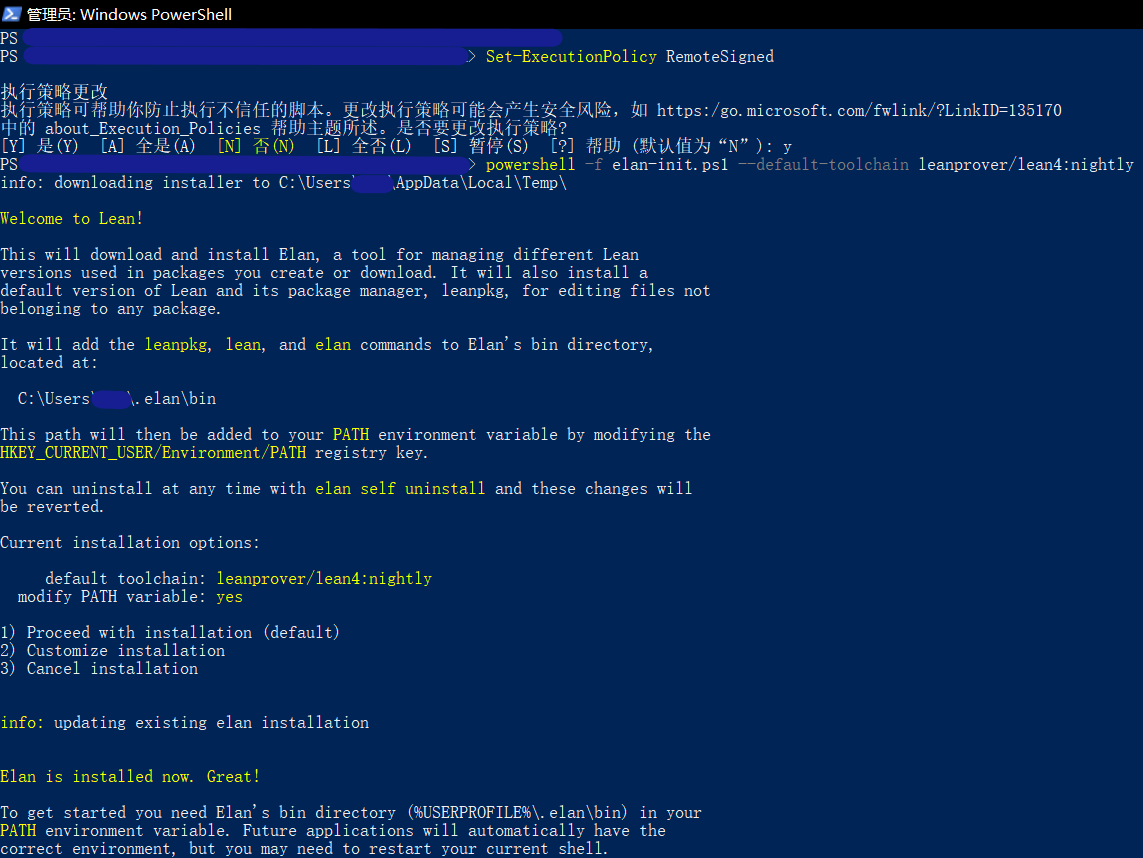

.elan文件夹,添加环境变量你的用户文件目录\.elan\bin。可能出现以下报错无法加载文件……因为在此系统上禁止运行此脚本”。解决方案是

1.用管理员身份运行Powershell;

2.输入命令

set-Executionpolicy Remotesigned,选择Y;然后就可以正常使用了。考虑到系统安全性,建议安装完成后将该选项改回默认值

N。效果如下图

由于本网站无法提供讨论区,欢迎向译者提供新的报错和解决方案,以丰富本页面。可邮件至subfishzhou@gmail.com

-

-

在终端中运行

$ elan self update # 以防你下载的不是最新版elan # 下载及应用最新的Lean4版本 (https://github.com/leanprover/lean4/releases) $ elan default leanprover/lean4:stable # 也可选择,只在当前目录下使用Lean4 $ elan override set leanprover/lean4:stable -

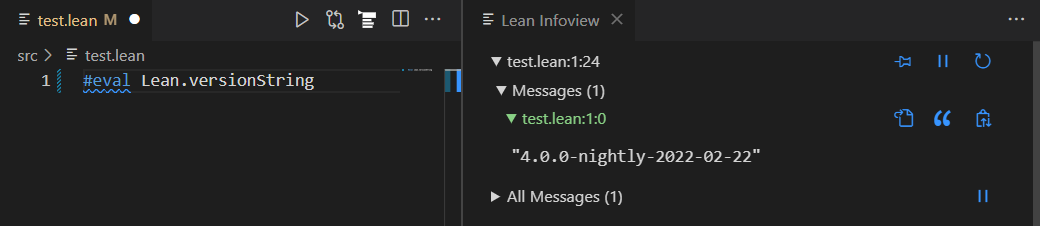

创建一个以

.lean为扩展名的新文件,并写入以下代码:#eval Lean.versionString你会看到语法高亮。当你把光标放在最后一行时,在右边有一个“Lean信息视图”,显示已经安装的Lean版本。

创建新Lean项目

用VS code打开一个新文件夹,你可以用两种方式创建新工程。

-

在终端中运行(

<your_project_name>替换为你自己起的名字)lake init <your_project_name>以创建一个名为your_project_name的空白新工程。如果你想把你的Lean程序编译成可执行文件,在终端中运行

lake build命令。如果你想在这个现有的工程中引用Mathlib4,你需要在

lakefile.lean文件中加入require mathlib from git "https://github.com/leanprover-community/mathlib4"然后在终端中运行

curl -L https://raw.githubusercontent.com/leanprover-community/mathlib4/master/lean-toolchain -o lean-toolchain -

如果你想直接创建一个引用Mathlib4的新工程,在终端中运行

lake +leanprover-community/mathlib4:lean-toolchain new <your_project_name> math以创建一个名为your_project_name的新工程。

使用Mathlib

更多内容请参考Mathlib Wiki

在你的项目文件夹下打开VS code,使用终端运行

lake update

lake exe cache get

如果你看到终端中显示了类似如下的提示:

Decompressing 1234 file(s)

unpacked in 12345 ms

同时你的项目文件夹中出现了lake-packages文件夹,那么证明你安装Mathlib成功了,重启系统即可使用。注意:你要在lake-packages所在的目录中运行VScode,才能让Lean使用Mathlib。

这里提供一个实例来测试你的安装:

import Mathlib.Data.Real.Basic

example (a b : ℝ) : a * b = b * a := by

rw [mul_comm a b]

如果你的Lean infoview没有任何报错,并且光标放在文件最后一行时会提示“No goals”,证明你的Mathlib已经正确安装了。

如果你想更新Mathlib,在终端中运行

curl -L https://raw.githubusercontent.com/leanprover-community/mathlib4/master/lean-toolchain -o lean-toolchain

lake update

lake exe cache get

依值类型论

依值类型论(Dependent type theory)是一种强大而富有表达力的语言,允许你表达复杂的数学断言,编写复杂的硬件和软件规范,并以自然和统一的方式对这两者进行推理。Lean是基于一个被称为构造演算(Calculus of Constructions)的依值类型论的版本,它拥有一个可数的非累积性宇宙(non-cumulative universe)的层次结构以及归纳类型(inductive type)。在本章结束时,你将学会一大部分。

普通类型论

“类型论”得名于其中每个表达式都有一个类型。举例:在一个给定的语境中,x + 0可能表示一个自然数,f可能表示一个定义在自然数上的函数。Lean中的自然数是任意精度的无符号整数。

这里的一些例子展示了如何声明对象以及检查其类型。

/- 定义一些常数 -/

def m : Nat := 1 -- m 是自然数

def n : Nat := 0

def b1 : Bool := true -- b1 是布尔型

def b2 : Bool := false

/- 检查类型 -/

#check m -- 输出: Nat

#check n

#check n + 0 -- Nat

#check m * (n + 0) -- Nat

#check b1 -- Bool

#check b1 && b2 -- "&&" is the Boolean and

#check b1 || b2 -- Boolean or

#check true -- Boolean "true"

/- 求值(Evaluate) -/

#eval 5 * 4 -- 20

#eval m + 2 -- 3

#eval b1 && b2 -- false

位于/-和-/之间的文本组成了一个注释块,会被Lean的编译器忽略。类似地,两条横线--后面也是注释。注释块可以嵌套,这样就可以“注释掉”一整块代码,这和任何程序语言都是一样的。

def关键字声明工作环境中的新常量符号。在上面的例子中,def m : Nat := 1定义了一个Nat类型的新常量m,其值为1。#check命令要求Lean给出它的类型,用于向系统询问信息的辅助命令都以井号(#)开头。#eval命令让Lean计算给出的表达式。你应该试试自己声明一些常量和检查一些表达式的类型。

普通类型论的强大之处在于,你可以从其他类型中构建新的类型。例如,如果a和b是类型,a -> b表示从a到b的函数类型,a × b表示由a元素与b元素配对构成的类型,也称为笛卡尔积。注意×是一个Unicode符号,可以使用\times或简写\tim来输入。合理使用Unicode提高了易读性,所有现代编辑器都支持它。在Lean标准库中,你经常看到希腊字母表示类型,Unicode符号→是->的更紧凑版本。

#check Nat → Nat -- 用"\to" or "\r"来打出这个箭头

#check Nat -> Nat -- 也可以用 ASCII 符号

#check Nat × Nat -- 用"\times"打出乘号

#check Prod Nat Nat -- 换成ASCII 符号

#check Nat → Nat → Nat

#check Nat → (Nat → Nat) -- 结果和上一个一样

#check Nat × Nat → Nat

#check (Nat → Nat) → Nat -- 一个“泛函”

#check Nat.succ -- Nat → Nat

#check (0, 1) -- Nat × Nat

#check Nat.add -- Nat → Nat → Nat

#check Nat.succ 2 -- Nat

#check Nat.add 3 -- Nat → Nat

#check Nat.add 5 2 -- Nat

#check (5, 9).1 -- Nat

#check (5, 9).2 -- Nat

#eval Nat.succ 2 -- 3

#eval Nat.add 5 2 -- 7

#eval (5, 9).1 -- 5

#eval (5, 9).2 -- 9

同样,你应该自己尝试一些例子。

让我们看一些基本语法。你可以通过输入\to或者\r或者\->来输入→。你也可以就用ASCII码->,所以表达式Nat -> Nat和Nat → Nat意思是一样的,都表示以一个自然数作为输入并返回一个自然数作为输出的函数类型。Unicode符号×是笛卡尔积,用\times输入。小写的希腊字母α,β,和γ等等常用来表示类型变量,可以用\a,\b,和\g来输入。

这里还有一些需要注意的事情。第一,函数f应用到值x上写为f x(例:Nat.succ 2)。第二,当写类型表达式时,箭头是右结合的;例如,Nat.add的类型是Nat → Nat → Nat,等价于Nat → (Nat → Nat)。

因此你可以把Nat.add看作一个函数,它接受一个自然数并返回另一个函数,该函数接受一个自然数并返回一个自然数。在类型论中,把Nat.add函数看作接受一对自然数作为输入并返回一个自然数作为输出的函数通常会更方便。系统允许你“部分应用”函数Nat.add,比如Nat.add 3具有类型Nat → Nat,即Nat.add 3返回一个“等待”第二个参数n的函数,然后可以继续写Nat.add 3 n。

注:取一个类型为

Nat × Nat → Nat的函数,然后“重定义”它,让它变成Nat → Nat → Nat类型,这个过程被称作柯里化(currying)。

如果你有m : Nat和n : Nat,那么(m, n)表示m和n组成的有序对,其类型为Nat × Nat。这个方法可以制造自然数对。反过来,如果你有p : Nat × Nat,之后你可以写p.1 : Nat和p.2 : Nat。这个方法用于提取它的两个组件。

类型作为对象

Lean所依据的依值类型论对普通类型论的其中一项升级是,类型本身(如Nat和Bool这些东西)也是对象,因此也具有类型。

#check Nat -- Type

#check Bool -- Type

#check Nat → Bool -- Type

#check Nat × Bool -- Type

#check Nat → Nat -- ...

#check Nat × Nat → Nat

#check Nat → Nat → Nat

#check Nat → (Nat → Nat)

#check Nat → Nat → Bool

#check (Nat → Nat) → Nat

上面的每个表达式都是类型为Type的对象。你也可以为类型声明新的常量:

def α : Type := Nat

def β : Type := Bool

def F : Type → Type := List

def G : Type → Type → Type := Prod

#check α -- Type

#check F α -- Type

#check F Nat -- Type

#check G α -- Type → Type

#check G α β -- Type

#check G α Nat -- Type

正如上面所示,你已经看到了一个类型为Type → Type → Type的函数例子,即笛卡尔积 Prod:

def α : Type := Nat

def β : Type := Bool

#check Prod α β -- Type

#check α × β -- Type

#check Prod Nat Nat -- Type

#check Nat × Nat -- Type

这里有另一个例子:给出任意类型α,那么类型List α是类型为α的元素的列表的类型。

def α : Type := Nat

#check List α -- Type

#check List Nat -- Type

看起来Lean中任何表达式都有一个类型,因此你可能会想到:Type自己的类型是什么?

#check Type -- Type 1

实际上,这是Lean系统的一个最微妙的方面:Lean的底层基础有无限的类型层次:

#check Type -- Type 1

#check Type 1 -- Type 2

#check Type 2 -- Type 3

#check Type 3 -- Type 4

#check Type 4 -- Type 5

可以将Type 0看作是一个由“小”或“普通”类型组成的宇宙。然后,Type 1是一个更大的类型范围,其中包含Type 0作为一个元素,而Type 2是一个更大的类型范围,其中包含Type 1作为一个元素。这个列表是不确定的,所以对于每个自然数n都有一个Type n。Type是Type 0的缩写:

#check Type

#check Type 0

然而,有些操作需要在类型宇宙上具有多态(polymorphic)。例如,List α应该对任何类型的α都有意义,无论α存在于哪种类型的宇宙中。所以函数List有如下的类型:

#check List -- Type u_1 → Type u_1

这里u_1是一个覆盖类型级别的变量。#check命令的输出意味着当α有类型Type n时,List α也有类型Type n。函数Prod具有类似的多态性:

#check Prod -- Type u_1 → Type u_2 → Type (max u_1 u_2)

你可以使用 universe 命令来声明宇宙变量,这样就可以定义多态常量:

universe u

def F (α : Type u) : Type u := Prod α α

#check F -- Type u → Type u

可以通过在定义F时提供universe参数来避免使用universe命令:

def F.{u} (α : Type u) : Type u := Prod α α

#check F -- Type u → Type u

函数抽象和求值

Lean提供 fun (或 λ)关键字用于从给定表达式创建函数,如下所示:

#check fun (x : Nat) => x + 5 -- Nat → Nat

#check λ (x : Nat) => x + 5 -- λ 和 fun 是同义词

#check fun x : Nat => x + 5 -- 同上

#check λ x : Nat => x + 5 -- 同上

你可以通过传递所需的参数来计算lambda函数:

#eval (λ x : Nat => x + 5) 10 -- 15

从另一个表达式创建函数的过程称为lambda 抽象。假设你有一个变量x : α和一个表达式t : β,那么表达式fun (x : α) => t或者λ (x : α) => t是一个类型为α → β的对象。这个从α到β的函数把任意x映射到t。

这有些例子:

#check fun x : Nat => fun y : Bool => if not y then x + 1 else x + 2

#check fun (x : Nat) (y : Bool) => if not y then x + 1 else x + 2

#check fun x y => if not y then x + 1 else x + 2 -- Nat → Bool → Nat

Lean将这三个例子解释为相同的表达式;在最后一个表达式中,Lean可以从表达式if not y then x + 1 else x + 2推断x和y的类型。

一些数学上常见的函数运算的例子可以用lambda抽象的项来描述:

def f (n : Nat) : String := toString n

def g (s : String) : Bool := s.length > 0

#check fun x : Nat => x -- Nat → Nat

#check fun x : Nat => true -- Nat → Bool

#check fun x : Nat => g (f x) -- Nat → Bool

#check fun x => g (f x) -- Nat → Bool

看看这些表达式的意思。表达式fun x : Nat => x代表Nat上的恒等函数,表达式fun x : Nat => true表示一个永远输出true的常值函数,表达式fun x : Nat => g (f x)表示f和g的复合。一般来说,你可以省略类型注释,让Lean自己推断它。因此你可以写fun x => g (f x)来代替fun x : Nat => g (f x)。

你可以以函数作为参数,通过给它们命名f和g,你可以在实现中使用这些函数:

#check fun (g : String → Bool) (f : Nat → String) (x : Nat) => g (f x)

-- (String → Bool) → (Nat → String) → Nat → Bool

你还可以以类型作为参数:

#check fun (α β γ : Type) (g : β → γ) (f : α → β) (x : α) => g (f x)

这个表达式表示一个接受三个类型α,β和γ和两个函数g : β → γ和f : α → β,并返回的g和f的复合的函数。(理解这个函数的类型需要理解依值乘积类型,下面将对此进行解释。)

lambda表达式的一般形式是fun x : α => t,其中变量x是一个“约束变量”:它实际上是一个占位符,其“作用域”没有扩展到表达式t之外。例如,表达式fun (b : β) (x : α) => b中的变量b与前面声明的常量b没有任何关系。事实上,这个表达式表示的函数与fun (u : β) (z : α) => u是一样的。形式上,可以通过给约束变量重命名来使形式相同的表达式被看作是alpha等价的,也就是被认为是“一样的”。Lean认识这种等价性。

注意到项t : α → β应用到项s : α上导出了表达式t s : β。回到前面的例子,为清晰起见给约束变量重命名,注意以下表达式的类型:

#check (fun x : Nat => x) 1 -- Nat

#check (fun x : Nat => true) 1 -- Bool

def f (n : Nat) : String := toString n

def g (s : String) : Bool := s.length > 0

#check

(fun (α β γ : Type) (u : β → γ) (v : α → β) (x : α) => u (v x)) Nat String Bool g f 0

-- Bool

表达式(fun x : Nat => x) 1的类型是Nat。实际上,应用(fun x : Nat => x)到1上返回的值是1。

#eval (fun x : Nat => x) 1 -- 1

#eval (fun x : Nat => true) 1 -- true

稍后你将看到这些项是如何计算的。现在,请注意这是依值类型论的一个重要特征:每个项都有一个计算行为,并支持“标准化”的概念。从原则上讲,两个可以化约为相同形式的项被称为“定义等价”。它们被Lean的类型检查器认为是“相同的”,并且Lean尽其所能地识别和支持这些识别结果。

Lean是个完备的编程语言。它有一个生成二进制可执行文件的编译器,和一个交互式解释器。你可以用#eval命令执行表达式,这也是测试你的函数的好办法。

注意到

#eval和#reduce不是等价的。#eval命令首先把Lean表达式编译成中间表示(intermediate representation, IR)然后用一个解释器来执行这个IR。某些内建类型(例如,Nat、String、Array)在IR中有更有效率的表示。IR支持使用对Lean不透明的外部函数。#reduce命令建立在一个化简引擎上,类似于在Lean的可信内核中使用的那个,它是负责检查和验证表达式和证明正确性的那一部分。它的效率不如#eval,且将所有外部函数视为不透明的常量。之后你将了解到这两个命令之间还有其他一些差异。

定义

def关键字提供了一个声明新对象的重要方式。

def double (x : Nat) : Nat :=

x + x

这很类似其他编程语言中的函数。名字double被定义为一个函数,它接受一个类型为Nat的输入参数x,其结果是x + x,因此它返回类型Nat。然后你可以调用这个函数:

#eval double 3 -- 6

在这种情况下你可以把def想成一种lambda。下面给出了相同的结果:

def double :=

fun (x : Nat) => x + x

当Lean有足够的信息来推断时,你可以省略类型声明。类型推断是Lean的重要组成部分:

def double : Nat → Nat :=

fun x => x + x

#eval double 3 -- 6

定义的一般形式是def foo : α := bar,其中α是表达式bar返回的类型。Lean通常可以推断类型α,但是精确写出它可以澄清你的意图,并且如果定义的右侧没有匹配你的类型,Lean将标记一个错误。

bar可以是任何一个表达式,不只是一个lambda表达式。因此def也可以用于给一些值命名,例如:

def pi := 3.141592654

def可以接受多个输入参数。比如定义两自然数之和:

def add (x y : Nat) :=

x + y

#eval add 3 2 -- 5

参数列表可以像这样分开写:

def add (x : Nat) (y : Nat) :=

x + y

#eval add (double 3) (7 + 9) -- 22

注意到这里我们使用了double函数来创建add函数的第一个参数。

你还可以在def中写一些更有趣的表达式:

def greater (x y : Nat) :=

if x > y then x

else y

你可能能猜到这个可以做什么。

还可以定义一个函数,该函数接受另一个函数作为输入。下面调用一个给定函数两次,将第一次调用的输出传递给第二次:

def doTwice (f : Nat → Nat) (x : Nat) : Nat :=

f (f x)

#eval doTwice double 2 -- 8

现在为了更抽象一点,你也可以指定类型参数等:

def compose (α β γ : Type) (g : β → γ) (f : α → β) (x : α) : γ :=

g (f x)

这句代码的意思是:函数compose首先接受任何两个函数作为参数,这其中两个函数各自接受一个输入。类型β → γ和α → β意思是要求第二个函数的输出类型必须与第一个函数的输入类型匹配,否则这两个函数将无法复合。

compose再接受一个类型为α的参数作为第二个函数(这里叫做f)的输入,通过这个函数之后的返回结果类型为β,再作为第一个函数(这里叫做g)的输入。第一个函数返回类型为γ,这就是compose函数最终返回的类型。

compose可以在任意的类型α β γ上使用,它可以复合任意两个函数,只要前一个的输出类型是后一个的输入类型。举例:

-- def compose (α β γ : Type) (g : β → γ) (f : α → β) (x : α) : γ :=

-- g (f x)

-- def double (x : Nat) : Nat :=

-- x + x

def square (x : Nat) : Nat :=

x * x

#eval compose Nat Nat Nat double square 3 -- 18

局部定义

Lean还允许你使用let关键字来引入“局部定义”。表达式let a := t1; t2定义等价于把t2中所有的a替换成t1的结果。

#check let y := 2 + 2; y * y -- Nat

#eval let y := 2 + 2; y * y -- 16

def twice_double (x : Nat) : Nat :=

let y := x + x; y * y

#eval twice_double 2 -- 16

这里twice_double x定义等价于(x + x) * (x + x)。

你可以连续使用多个let命令来进行多次替换:

#check let y := 2 + 2; let z := y + y; z * z -- Nat

#eval let y := 2 + 2; let z := y + y; z * z -- 64

换行可以省略分号;。

def t (x : Nat) : Nat :=

let y := x + x

y * y

表达式let a := t1; t2的意思很类似(fun a => t2) t1,但是这两者并不一样。前者中你要把t2中每一个a的实例考虑成t1的一个缩写。后者中a是一个变量,表达式fun a => t2不依赖于a的取值而可以单独具有意义。作为一个对照,考虑为什么下面的foo定义是合法的,但bar不行(因为在确定了x所属的a是什么之前,是无法让它+ 2的)。

def foo := let a := Nat; fun x : a => x + 2

/-

def bar := (fun a => fun x : a => x + 2) Nat

-/

变量和小节

考虑下面这三个函数定义:

def compose (α β γ : Type) (g : β → γ) (f : α → β) (x : α) : γ :=

g (f x)

def doTwice (α : Type) (h : α → α) (x : α) : α :=

h (h x)

def doThrice (α : Type) (h : α → α) (x : α) : α :=

h (h (h x))

Lean提供variable指令来让这些声明变得紧凑:

variable (α β γ : Type)

def compose (g : β → γ) (f : α → β) (x : α) : γ :=

g (f x)

def doTwice (h : α → α) (x : α) : α :=

h (h x)

def doThrice (h : α → α) (x : α) : α :=

h (h (h x))

你可以声明任意类型的变量,不只是Type类型:

variable (α β γ : Type)

variable (g : β → γ) (f : α → β) (h : α → α)

variable (x : α)

def compose := g (f x)

def doTwice := h (h x)

def doThrice := h (h (h x))

#print compose

#print doTwice

#print doThrice

输出结果表明所有三组定义具有完全相同的效果。

variable命令指示Lean将声明的变量作为约束变量插入定义中,这些定义通过名称引用它们。Lean足够聪明,它能找出定义中显式或隐式使用哪些变量。因此在写定义时,你可以将α、β、γ、g、f、h和x视为固定的对象,并让Lean自动抽象这些定义。

当以这种方式声明时,变量将一直保持存在,直到所处理的文件结束。然而,有时需要限制变量的作用范围。Lean提供了小节标记section来实现这个目的:

section useful

variable (α β γ : Type)

variable (g : β → γ) (f : α → β) (h : α → α)

variable (x : α)

def compose := g (f x)

def doTwice := h (h x)

def doThrice := h (h (h x))

end useful

当一个小节结束后,变量不再发挥作用。

你不需要缩进一个小节中的行。你也不需要命名一个小节,也就是说,你可以使用一个匿名的section /end对。但是,如果你确实命名了一个小节,你必须使用相同的名字关闭它。小节也可以嵌套,这允许你逐步增加声明新变量。

命名空间

Lean可以让你把定义放进一个“命名空间”(namespace)里,并且命名空间也是层次化的:

namespace Foo

def a : Nat := 5

def f (x : Nat) : Nat := x + 7

def fa : Nat := f a

def ffa : Nat := f (f a)

#check a

#check f

#check fa

#check ffa

#check Foo.fa

end Foo

-- #check a -- error

-- #check f -- error

#check Foo.a

#check Foo.f

#check Foo.fa

#check Foo.ffa

open Foo

#check a

#check f

#check fa

#check Foo.fa

当你声明你在命名空间Foo中工作时,你声明的每个标识符都有一个前缀Foo.。在打开的命名空间中,可以通过较短的名称引用标识符,但是关闭命名空间后,必须使用较长的名称。与section不同,命名空间需要一个名称。只有一个匿名命名空间在根级别上。

open命令使你可以在当前使用较短的名称。通常,当你导入一个模块时,你会想打开它包含的一个或多个命名空间,以访问短标识符。但是,有时你希望将这些信息保留在一个完全限定的名称中,例如,当它们与你想要使用的另一个命名空间中的标识符冲突时。因此,命名空间为你提供了一种在工作环境中管理名称的方法。

例如,Lean把和列表相关的定义和定理都放在了命名空间List之中。

#check List.nil

#check List.cons

#check List.map

open List命令允许你使用短一点的名字:

open List

#check nil

#check cons

#check map

像小节一样,命名空间也是可以嵌套的:

namespace Foo

def a : Nat := 5

def f (x : Nat) : Nat := x + 7

def fa : Nat := f a

namespace Bar

def ffa : Nat := f (f a)

#check fa

#check ffa

end Bar

#check fa

#check Bar.ffa

end Foo

#check Foo.fa

#check Foo.Bar.ffa

open Foo

#check fa

#check Bar.ffa

关闭的命名空间可以之后重新打开,甚至是在另一个文件里:

namespace Foo

def a : Nat := 5

def f (x : Nat) : Nat := x + 7

def fa : Nat := f a

end Foo

#check Foo.a

#check Foo.f

namespace Foo

def ffa : Nat := f (f a)

end Foo

与小节一样,嵌套的名称空间必须按照打开的顺序关闭。命名空间和小节有不同的用途:命名空间组织数据,小节声明变量,以便在定义中插入。小节对于分隔set_option和open等命令的范围也很有用。

然而,在许多方面,namespace ... end结构块和section ... end表现出来的特征是一样的。尤其是你在命名空间中使用variable命令时,它的作用范围被限制在命名空间里。类似地,如果你在命名空间中使用open命令,它的效果在命名空间关闭后消失。

依值类型论“依赖”着什么?

简单地说,类型可以依赖于参数。你已经看到了一个很好的例子:类型List α依赖于参数α,而这种依赖性是区分List Nat和List Bool的关键。另一个例子,考虑类型Vector α n,即长度为n的α元素的向量类型。这个类型取决于两个参数:向量中元素的类型α : Type和向量的长度n : Nat。

假设你希望编写一个函数cons,它在列表的开头插入一个新元素。cons应该有什么类型?这样的函数是多态的(polymorphic):你期望Nat,Bool或任意类型α的cons函数表现相同的方式。因此,将类型作为cons的第一个参数是有意义的,因此对于任何类型α,cons α是类型α列表的插入函数。换句话说,对于每个α,cons α是将元素a : α插入列表as : List α的函数,并返回一个新的列表,因此有cons α a as : List α。

很明显,cons α具有类型α → List α → List α,但是cons具有什么类型?如果我们假设是Type → α → list α → list α,那么问题在于,这个类型表达式没有意义:α没有任何的所指,但它实际上指的是某个类型Type。换句话说,假设α : Type是函数的首个参数,之后的两个参数的类型是α和List α,它们依赖于首个参数α。

def cons (α : Type) (a : α) (as : List α) : List α :=

List.cons a as

#check cons Nat -- Nat → List Nat → List Nat

#check cons Bool -- Bool → List Bool → List Bool

#check cons -- (α : Type) → α → List α → List α

这就是依值函数类型,或者依值箭头类型的一个例子。给定α : Type和β : α → Type,把β考虑成α之上的类型族,也就是说,对于每个a : α都有类型β a。在这种情况下,类型(a : α) → β a表示的是具有如下性质的函数f的类型:对于每个a : α,f a是β a的一个元素。换句话说,f返回值的类型取决于其输入。

注意到(a : α) → β对于任意表达式β : Type都有意义。当β的值依赖于a(例如,在前一段的表达式β a),(a : α) → β表示一个依值函数类型。当β的值不依赖于a,(a : α) → β与类型α → β无异。实际上,在依值类型论(以及Lean)中,α → β表达的意思就是当β的值不依赖于a时的(a : α) → β。【注】

译者注:在依值类型论的数学符号体系中,依值类型是用

Π符号来表达的,在Lean 3中还使用这种表达,例如Π x : α, β x。Lean 4抛弃了这种对新手不友好的写法,但是沿袭了三代中另外两种意义更明朗的写法:forall x : α, β x和∀ x : α, β x。这几个表达式都和(x : α) → β x同义。但是个人感觉本教程这一段的讲法也对新手不友好,(x : α) → β x这种写法在引入“构造子”之后意义会更明朗一些(见下一个注释),当前反倒是forall x : α, β x这种写法对于来自数学背景的读者更加清楚明白,关于前一种符号在量词与等价一章中有更详细的说明。同时,依值类型有着更丰富的引入动机,推荐读者寻找一些拓展读物。

回到列表的例子,你可以使用#check命令来检查下列的List函数。@符号以及圆括号和花括号之间的区别将在后面解释。

#check @List.cons -- {α : Type u_1} → α → List α → List α

#check @List.nil -- {α : Type u_1} → List α

#check @List.length -- {α : Type u_1} → List α → Nat

#check @List.append -- {α : Type u_1} → List α → List α → List α

就像依值函数类型(a : α) → β a通过允许β依赖α从而推广了函数类型α → β,依值笛卡尔积类型(a : α) × β a同样推广了笛卡尔积α × β。依值积类型又称为sigma类型,可写成Σ a : α, β a。你可以用⟨a, b⟩或者Sigma.mk a b来创建依值对。

universe u v

def f (α : Type u) (β : α → Type v) (a : α) (b : β a) : (a : α) × β a :=

⟨a, b⟩

def g (α : Type u) (β : α → Type v) (a : α) (b : β a) : Σ a : α, β a :=

Sigma.mk a b

def h1 (x : Nat) : Nat :=

(f Type (fun α => α) Nat x).2

#eval h1 5 -- 5

def h2 (x : Nat) : Nat :=

(g Type (fun α => α) Nat x).2

#eval h2 5 -- 5

函数f和g表达的是同样的函数。

隐参数

假设我们有一个列表的实现如下:

universe u

def Lst (α : Type u) : Type u := List α

def Lst.cons (α : Type u) (a : α) (as : Lst α) : Lst α := List.cons a as

def Lst.nil (α : Type u) : Lst α := List.nil

def Lst.append (α : Type u) (as bs : Lst α) : Lst α := List.append as bs

#check Lst -- Type u_1 → Type u_1

#check Lst.cons -- (α : Type u_1) → α → Lst α → Lst α

#check Lst.nil -- (α : Type u_1) → Lst α

#check Lst.append -- (α : Type u_1) → Lst α → Lst α → Lst α

然后,你可以建立一个自然数列表如下:

#check Lst.cons Nat 0 (Lst.nil Nat)

def as : Lst Nat := Lst.nil Nat

def bs : Lst Nat := Lst.cons Nat 5 (Lst.nil Nat)

#check Lst.append Nat as bs

由于构造子对类型是多态的【注】,我们需要重复插入类型Nat作为一个参数。但是这个信息是多余的:我们可以推断表达式Lst.cons Nat 5 (Lst.nil Nat)中参数α的类型,这是通过第二个参数5的类型是Nat来实现的。类似地,我们可以推断Lst.nil Nat中参数的类型,这是通过它作为函数Lst.cons的一个参数,且这个函数在这个位置需要接收的是一个具有Lst α类型的参数来实现的。

译者注:“构造子”(constructor)的概念前文未加解释,对类型论不熟悉的读者可能会困惑。它指的是一种“依值类型的类型”,也可以看作“类型的构造器”,例如

λ α : α -> α甚至可看成⋆ -> ⋆。当给α或者⋆赋予一个具体的类型时,这个表达式就成为了一个类型。前文中(x : α) → β x中的β就可以看成一个构造子,(x : α)就是传进的类型参数。原句“构造子对类型是多态的”意为给构造子中放入不同类型时它会变成不同类型。

这是依值类型论的一个主要特征:项包含大量信息,而且通常可以从上下文推断出一些信息。在Lean中,我们使用下划线_来指定系统应该自动填写信息。这就是所谓的“隐参数”。

#check Lst.cons _ 0 (Lst.nil _)

def as : Lst Nat := Lst.nil _

def bs : Lst Nat := Lst.cons _ 5 (Lst.nil _)

#check Lst.append _ as bs

然而,敲这么多下划线仍然很无聊。当一个函数接受一个通常可以从上下文推断出来的参数时,Lean允许你指定该参数在默认情况下应该保持隐式。这是通过将参数放入花括号来实现的,如下所示:

universe u

def Lst (α : Type u) : Type u := List α

def Lst.cons {α : Type u} (a : α) (as : Lst α) : Lst α := List.cons a as

def Lst.nil {α : Type u} : Lst α := List.nil

def Lst.append {α : Type u} (as bs : Lst α) : Lst α := List.append as bs

#check Lst.cons 0 Lst.nil

def as : Lst Nat := Lst.nil

def bs : Lst Nat := Lst.cons 5 Lst.nil

#check Lst.append as bs

唯一改变的是变量声明中α : Type u周围的花括号。我们也可以在函数定义中使用这个技巧:

universe u

def ident {α : Type u} (x : α) := x

#check ident -- ?m → ?m

#check ident 1 -- Nat

#check ident "hello" -- String

#check @ident -- {α : Type u_1} → α → α

这使得ident的第一个参数是隐式的。从符号上讲,这隐藏了类型的说明,使它看起来好像ident只是接受任何类型的参数。事实上,函数id在标准库中就是以这种方式定义的。我们在这里选择一个非传统的名字只是为了避免名字的冲突。

variable命令也可以用这种技巧来来把变量变成隐式的:

universe u

section

variable {α : Type u}

variable (x : α)

def ident := x

end

#check ident

#check ident 4

#check ident "hello"

Lean有非常复杂的机制来实例化隐参数,我们将看到它们可以用来推断函数类型、谓词,甚至证明。实例化这些“洞”或“占位符”的过程通常被称为繁饰(elaboration)。隐参数的存在意味着有时可能没有足够的信息来精确地确定表达式的含义。像id或List.nil这样的表达式被认为是“多态的”,因为它可以在不同的上下文中具有不同的含义。

可以通过写(e : T)来指定表达式e的类型T。这就指导Lean的繁饰器在试图解决隐式参数时使用值T作为e的类型。在下面的第二个例子中,这种机制用于指定表达式id和List.nil所需的类型:

#check List.nil -- List ?m

#check id -- ?m → ?m

#check (List.nil : List Nat) -- List Nat

#check (id : Nat → Nat) -- Nat → Nat

Lean中数字是重载的,但是当数字的类型不能被推断时,Lean默认假设它是一个自然数。因此,下面的前两个#check命令中的表达式以同样的方式进行了繁饰,而第三个#check命令将2解释为整数。

#check 2 -- Nat

#check (2 : Nat) -- Nat

#check (2 : Int) -- Int

然而,有时我们可能会发现自己处于这样一种情况:我们已经声明了函数的参数是隐式的,但现在想显式地提供参数。如果foo是有隐参数的函数,符号@foo表示所有参数都是显式的该函数。

#check @id -- {α : Type u_1} → α → α

#check @id Nat -- Nat → Nat

#check @id Bool -- Bool → Bool

#check @id Nat 1 -- Nat

#check @id Bool true -- Bool

第一个#check命令给出了标识符的类型id,没有插入任何占位符。而且,输出表明第一个参数是隐式的。

命题和证明

前一章你已经看到了在Lean中定义对象和函数的一些方法。在本章中,我们还将开始解释如何用依值类型论的语言来编写数学命题和证明。

命题即类型

证明在依值类型论语言中定义的对象的断言(assertion)的一种策略是在定义语言之上分层断言语言和证明语言。但是,没有理由以这种方式重复使用多种语言:依值类型论是灵活和富有表现力的,我们也没有理由不能在同一个总框架中表示断言和证明。

例如,我们可引入一种新类型Prop,来表示命题,然后引入用其他命题构造新命题的构造子。

def Implies (p q : Prop) : Prop := p → q

#check And -- Prop → Prop → Prop

#check Or -- Prop → Prop → Prop

#check Not -- Prop → Prop

#check Implies -- Prop → Prop → Prop

variable (p q r : Prop)

#check And p q -- Prop

#check Or (And p q) r -- Prop

#check Implies (And p q) (And q p) -- Prop

对每个元素p : Prop,可以引入另一个类型Proof p,作为p的证明的类型。“公理”是这个类型中的常值。

structure Proof (p : Prop) : Type where

proof : p

#check Proof -- Proof : Prop → Type

axiom and_comm (p q : Prop) : Proof (Implies (And p q) (And q p))

variable (p q : Prop)

#check and_comm p q -- Proof (Implies (And p q) (And q p))

然而,除了公理之外,我们还需要从旧证明中建立新证明的规则。例如,在许多命题逻辑的证明系统中,我们有肯定前件式(modus ponens)推理规则:

如果能证明

Implies p q和p,则能证明q。

我们可以如下地表示它:

axiom modus_ponens : (p q : Prop) → Proof (Implies p q) → Proof p → Proof q

命题逻辑的自然演绎系统通常也依赖于以下规则:

当假设

p成立时,如果我们能证明q. 则我们能证明Implies p q.

我们可以如下地表示它:

axiom implies_intro : (p q : Prop) → (Proof p → Proof q) → Proof (Implies p q)

这个功能让我们可以合理地搭建断言和证明。确定表达式t是p的证明,只需检查t具有类型Proof p。

可以做一些简化。首先,我们可以通过将Proof p和p本身合并来避免重复地写Proof这个词。换句话说,只要我们有p : Prop,我们就可以把p解释为一种类型,也就是它的证明类型。然后我们可以把t : p读作t是p的证明。

此外,我们可以在Implies p q和p → q之间来回切换。换句话说,命题p和q之间的含义对应于一个函数,它将p的任何元素接受为q的一个元素。因此,引入连接词Implies是完全多余的:我们可以使用依值类型论中常见的函数空间构造子p → q作为我们的蕴含概念。

这是在构造演算(Calculus of Constructions)中遵循的方法,因此在Lean中也是如此。自然演绎证明系统中的蕴含规则与控制函数抽象(abstraction)和应用(application)的规则完全一致,这是Curry-Howard同构的一个实例,有时也被称为命题即类型。事实上,类型Prop是上一章描述的类型层次结构的最底部Sort 0的语法糖。此外,Type u也只是Sort (u+1)的语法糖。Prop有一些特殊的特性,但像其他类型宇宙一样,它在箭头构造子下是封闭的:如果我们有p q : Prop,那么p → q : Prop。

至少有两种将命题作为类型来思考的方法。对于那些对逻辑和数学中的构造主义者来说,这是对命题含义的忠实诠释:命题p代表了一种数据类型,即构成证明的数据类型的说明。p的证明就是正确类型的对象t : p。

非构造主义者可以把它看作是一种简单的编码技巧。对于每个命题p,我们关联一个类型,如果p为假,则该类型为空,如果p为真,则有且只有一个元素,比如*。在后一种情况中,让我们说(与之相关的类型)p被占据(inhabited)。恰好,函数应用和抽象的规则可以方便地帮助我们跟踪Prop的哪些元素是被占据的。所以构造一个元素t : p告诉我们p确实是正确的。你可以把p的占据者想象成“p为真”的事实。对p → q的证明使用“p是真的”这个事实来得到“q是真的”这个事实。

事实上,如果p : Prop是任何命题,那么Lean的内核将任意两个元素t1 t2 : p看作定义相等,就像它把(fun x => t) s和t[s/x]看作定义等价。这就是所谓的“证明无关性”(proof irrelevance)。这意味着,即使我们可以把证明t : p当作依值类型论语言中的普通对象,它们除了p是真的这一事实之外,没有其他信息。

我们所建议的思考“命题即类型”范式的两种方式在一个根本性的方面有所不同。从构造的角度看,证明是抽象的数学对象,它被依值类型论中的合适表达式所表示。相反,如果我们从上述编码技巧的角度考虑,那么表达式本身并不表示任何有趣的东西。相反,是我们可以写下它们并检查它们是否有良好的类型这一事实确保了有关命题是真的。换句话说,表达式本身就是证明。

在下面的论述中,我们将在这两种说话方式之间来回切换,有时说一个表达式“构造”或“产生”或“返回”一个命题的证明,有时则简单地说它“是”这样一个证明。这类似于计算机科学家偶尔会模糊语法和语义之间的区别,有时说一个程序“计算”某个函数,有时又说该程序“是”该函数。

为了用依值类型论的语言正式表达一个数学断言,我们需要展示一个项p : Prop。为了证明该断言,我们需要展示一个项t : p。Lean的任务,作为一个证明助手,是帮助我们构造这样一个项t,并验证它的格式是否良好,类型是否正确。

以“命题即类型”的方式工作

在“命题即类型”范式中,只涉及→的定理可以通过lambda抽象和应用来证明。在Lean中,theorem命令引入了一个新的定理:

variable {p : Prop}

variable {q : Prop}

theorem t1 : p → q → p := fun hp : p => fun hq : q => hp

这与上一章中常量函数的定义完全相同,唯一的区别是参数是Prop的元素,而不是Type的元素。直观地说,我们对p → q → p的证明假设p和q为真,并使用第一个假设(平凡地)建立结论p为真。

请注意,theorem命令实际上是def命令的一个翻版:在命题和类型对应下,证明定理p → q → p实际上与定义关联类型的元素是一样的。对于内核类型检查器,这两者之间没有区别。

然而,定义和定理之间有一些实用的区别。正常情况下,永远没有必要展开一个定理的“定义”;通过证明无关性,该定理的任何两个证明在定义上都是相等的。一旦一个定理的证明完成,通常我们只需要知道该证明的存在;证明是什么并不重要。鉴于这一事实,Lean将证明标记为不可还原(irreducible),作为对解析器(更确切地说,是繁饰器)的提示,在处理文件时一般不需要展开它。事实上,Lean通常能够并行地处理和检查证明,因为评估一个证明的正确性不需要知道另一个证明的细节。

和定义一样,#print命令可以展示一个定理的证明。

theorem t1 : p → q → p := fun hp : p => fun hq : q => hp

#print t1

注意,lambda抽象hp : p和hq : q可以被视为t1的证明中的临时假设。Lean还允许我们通过show语句明确指定最后一个项hp的类型。

theorem t1 : p → q → p :=

fun hp : p =>

fun hq : q =>

show p from hp --试试改成 show q from hp 会怎样?

添加这些额外的信息可以提高证明的清晰度,并有助于在编写证明时发现错误。show命令只是注释类型,而且在内部,我们看到的所有关于t1的表示都产生了相同的项。

与普通定义一样,我们可以将lambda抽象的变量移到冒号的左边:

theorem t1 (hp : p) (hq : q) : p := hp

#print t1 -- p → q → p

现在我们可以把定理t1作为一个函数应用。

theorem t1 (hp : p) (hq : q) : p := hp

axiom hp : p

theorem t2 : q → p := t1 hp

这里,axiom声明假定存在给定类型的元素,因此可能会破坏逻辑一致性。例如,我们可以使用它来假设空类型False有一个元素:

axiom unsound : False

-- false可导出一切

theorem ex : 1 = 0 :=

False.elim unsound

声明“公理”hp : p等同于声明p为真,正如hp所证明的那样。应用定理t1 : p → q → p到事实hp : p(也就是p为真)得到定理t1 hp : q → p。

回想一下,我们也可以这样写定理t1:

theorem t1 {p q : Prop} (hp : p) (hq : q) : p := hp

#print t1

t1的类型现在是∀ {p q : Prop}, p → q → p。我们可以把它理解为“对于每一对命题p q,我们都有p → q → p”。例如,我们可以将所有参数移到冒号的右边:

theorem t1 : ∀ {p q : Prop}, p → q → p :=

fun {p q : Prop} (hp : p) (hq : q) => hp

如果p和q被声明为变量,Lean会自动为我们推广它们:

variable {p q : Prop}

theorem t1 : p → q → p := fun (hp : p) (hq : q) => hp

事实上,通过命题即类型的对应关系,我们可以声明假设hp为p,作为另一个变量:

variable {p q : Prop}

variable (hp : p)

theorem t1 : q → p := fun (hq : q) => hp

Lean检测到证明使用hp,并自动添加hp : p作为前提。在所有情况下,命令#print t1仍然会产生∀ p q : Prop, p → q → p。这个类型也可以写成∀ (p q : Prop) (hp : p) (hq :q), p,因为箭头仅仅表示一个箭头类型,其中目标不依赖于约束变量。

当我们以这种方式推广t1时,我们就可以将它应用于不同的命题对,从而得到一般定理的不同实例。

theorem t1 (p q : Prop) (hp : p) (hq : q) : p := hp

variable (p q r s : Prop)

#check t1 p q -- p → q → p

#check t1 r s -- r → s → r

#check t1 (r → s) (s → r) -- (r → s) → (s → r) → r → s

variable (h : r → s)

#check t1 (r → s) (s → r) h -- (s → r) → r → s

同样,使用命题即类型对应,类型为r → s的变量h可以看作是r → s存在的假设或前提。

作为另一个例子,让我们考虑上一章讨论的组合函数,现在用命题代替类型。

variable (p q r s : Prop)

theorem t2 (h₁ : q → r) (h₂ : p → q) : p → r :=

fun h₃ : p =>

show r from h₁ (h₂ h₃)

作为一个命题逻辑定理,t2是什么意思?

注意,数字unicode下标输入方式为\0,\1,\2,...。

命题逻辑

Lean定义了所有标准的逻辑连接词和符号。命题连接词有以下表示法:

| Ascii | Unicode | 编辑器缩写 | 定义 |

|---|---|---|---|

| True | True | ||

| False | False | ||

| Not | ¬ | \not, \neg | Not |

| /\ | ∧ | \and | And |

| \/ | ∨ | \or | Or |

| -> | → | \to, \r, \imp | |

| <-> | ↔ | \iff, \lr | Iff |

它们都接收Prop值。

variable (p q : Prop)

#check p → q → p ∧ q

#check ¬p → p ↔ False

#check p ∨ q → q ∨ p

操作符的优先级如下:¬ > ∧ > ∨ > → > ↔。举例:a ∧ b → c ∨ d ∧ e意为(a ∧ b) → (c ∨ (d ∧ e))。→等二元关系是右结合的。所以如果我们有p q r : Prop,表达式p → q → r读作“如果p,那么如果q,那么r”。这是p ∧ q → r的柯里化形式。

在上一章中,我们观察到lambda抽象可以被看作是→的“引入规则”,展示了如何“引入”或建立一个蕴含。应用可以看作是一个“消去规则”,展示了如何在证明中“消去”或使用一个蕴含。其他的命题连接词在Lean的库Prelude.core文件中定义。(参见导入文件以获得关于库层次结构的更多信息),并且每个连接都带有其规范引入和消去规则。

合取

表达式And.intro h1 h2是p ∧ q的证明,它使用了h1 : p和h2 : q的证明。通常把And.intro称为合取引入规则。下面的例子我们使用And.intro来创建p → q → p ∧ q的证明。

variable (p q : Prop)

example (hp : p) (hq : q) : p ∧ q := And.intro hp hq

#check fun (hp : p) (hq : q) => And.intro hp hq

example命令声明了一个没有名字也不会永久保存的定理。本质上,它只是检查给定项是否具有指定的类型。它便于说明,我们将经常使用它。

表达式And.left h从h : p ∧ q建立了一个p的证明。类似地,And.right h是q的证明。它们常被称为左或右合取消去规则。

variable (p q : Prop)

example (h : p ∧ q) : p := And.left h

example (h : p ∧ q) : q := And.right h

我们现在可以证明p ∧ q → q ∧ p:

variable (p q : Prop)

example (h : p ∧ q) : q ∧ p :=

And.intro (And.right h) (And.left h)

请注意,引入和消去与笛卡尔积的配对和投影操作类似。区别在于,给定hp : p和hq : q,And.intro hp hq具有类型p ∧ q : Prop,而Prod hp hq具有类型p × q : Type。∧和×之间的相似性是Curry-Howard同构的另一个例子,但与蕴涵和函数空间构造子不同,在Lean中∧和×是分开处理的。然而,通过类比,我们刚刚构造的证明类似于交换一对中的元素的函数。

我们将在结构体和记录一章中看到Lean中的某些类型是Structures,也就是说,该类型是用单个规范的构造子定义的,该构造子从一系列合适的参数构建该类型的一个元素。对于每一组p q : Prop, p ∧ q就是一个例子:构造一个元素的规范方法是将And.intro应用于合适的参数hp : p和hq : q。Lean允许我们使用匿名构造子表示法⟨arg1, arg2, ...⟩在此类情况下,当相关类型是归纳类型并可以从上下文推断时。特别地,我们经常可以写入⟨hp, hq⟩,而不是And.intro hp hq:

variable (p q : Prop)

variable (hp : p) (hq : q)

#check (⟨hp, hq⟩ : p ∧ q)

尖括号可以用\<和\>打出来。

Lean提供了另一个有用的语法小工具。给定一个归纳类型Foo的表达式e(可能应用于一些参数),符号e.bar是Foo.bar e的缩写。这为访问函数提供了一种方便的方式,而无需打开名称空间。例如,下面两个表达的意思是相同的:

variable (xs : List Nat)

#check List.length xs

#check xs.length

给定h : p ∧ q,我们可以写h.left来表示And.left h以及h.right来表示And.right h。因此我们可以简写上面的证明如下:

variable (p q : Prop)

example (h : p ∧ q) : q ∧ p :=

⟨h.right, h.left⟩

在简洁和含混不清之间有一条微妙的界限,以这种方式省略信息有时会使证明更难阅读。但对于像上面这样简单的结构,当h的类型和结构的目标很突出时,符号是干净和有效的。

像And.这样的迭代结构是很常见的。Lean还允许你将嵌套的构造函数向右结合,这样这两个证明是等价的:

variable (p q : Prop)

example (h : p ∧ q) : q ∧ p ∧ q:=

⟨h.right, ⟨h.left, h.right⟩⟩

example (h : p ∧ q) : q ∧ p ∧ q:=

⟨h.right, h.left, h.right⟩

这一点也很常用。

析取

表达式Or.intro_left q hp从证明hp : p建立了p ∨ q的证明。类似地,Or.intro_right p hq从证明hq : q建立了p ∨ q的证明。这是左右析取引入规则。

variable (p q : Prop)

example (hp : p) : p ∨ q := Or.intro_left q hp

example (hq : q) : p ∨ q := Or.intro_right p hq

析取消去规则稍微复杂一点。这个想法是,我们可以从p ∨ q证明r,通过从p证明r,且从q证明r。换句话说,它是一种逐情况证明。在表达式Or.elim hpq hpr hqr中,Or.elim接受三个论证,hpq : p ∨ q,hpr : p → r和hqr : q → r,生成r的证明。在下面的例子中,我们使用Or.elim证明p ∨ q → q ∨ p。

variable (p q r : Prop)

example (h : p ∨ q) : q ∨ p :=

Or.elim h

(fun hp : p =>

show q ∨ p from Or.intro_right q hp)

(fun hq : q =>

show q ∨ p from Or.intro_left p hq)

在大多数情况下,Or.intro_right和Or.intro_left的第一个参数可以由Lean自动推断出来。因此,Lean提供了Or.inr和Or.inl作为Or.intro_right _和Or.intro_left _的缩写。因此,上面的证明项可以写得更简洁:

variable (p q r : Prop)

example (h : p ∨ q) : q ∨ p :=

Or.elim h (fun hp => Or.inr hp) (fun hq => Or.inl hq)

Lean的完整表达式中有足够的信息来推断hp和hq的类型。但是在较长的版本中使用类型注释可以使证明更具可读性,并有助于捕获和调试错误。

因为Or有两个构造子,所以不能使用匿名构造子表示法。但我们仍然可以写h.elim而不是Or.elim h,不过你需要注意这些缩写是增强还是降低了可读性:

variable (p q r : Prop)

example (h : p ∨ q) : q ∨ p :=

h.elim (fun hp => Or.inr hp) (fun hq => Or.inl hq)

否定和假言

否定¬p真正的定义是p → False,所以我们通过从p导出一个矛盾来获得¬p。类似地,表达式hnp hp从hp : p和hnp : ¬p产生一个False的证明。下一个例子用所有这些规则来证明(p → q) → ¬q → ¬p。(¬符号可以由\not或者\neg来写出。)

variable (p q : Prop)

example (hpq : p → q) (hnq : ¬q) : ¬p :=

fun hp : p =>

show False from hnq (hpq hp)

连接词False只有一个消去规则False.elim,它表达了一个事实,即矛盾能导出一切。这个规则有时被称为ex falso 【ex falso sequitur quodlibet(无稽之谈)的缩写】,或爆炸原理。

variable (tp q : Prop)

example (hp : p) (hnp : ¬p) : q := False.elim (hnp hp)

假命题导出任意的事实q,是False.elim的一个隐参数,而且是自动推断出来的。这种从相互矛盾的假设中推导出任意事实的模式很常见,用absurd来表示。

variable (p q : Prop)

example (hp : p) (hnp : ¬p) : q := absurd hp hnp

证明¬p → q → (q → p) → r:

variable (p q r : Prop)

example (hnp : ¬p) (hq : q) (hqp : q → p) : r :=

absurd (hqp hq) hnp

顺便说一句,就像False只有一个消去规则,True只有一个引入规则True.intro : true。换句话说,True就是真,并且有一个标准证明True.intro。

逻辑等价

表达式Iff.intro h1 h2从h1 : p → q和h2 : q → p生成了p ↔ q的证明。表达式Iff.mp h从h : p ↔ q生成了p → q的证明。表达式Iff.mpr h从h : p ↔ q生成了q → p的证明。下面是p ∧ q ↔ q ∧ p的证明:

variable (p q : Prop)

theorem and_swap : p ∧ q ↔ q ∧ p :=

Iff.intro

(fun h : p ∧ q =>

show q ∧ p from And.intro (And.right h) (And.left h))

(fun h : q ∧ p =>

show p ∧ q from And.intro (And.right h) (And.left h))

#check and_swap p q -- p ∧ q ↔ q ∧ p

variable (h : p ∧ q)

example : q ∧ p := Iff.mp (and_swap p q) h

我们可以用匿名构造子表示法来,从正反两个方向的证明,来构建p ↔ q的证明。我们也可以使用.符号连接mp和mpr。因此,前面的例子可以简写如下:

variable (p q : Prop)

theorem and_swap : p ∧ q ↔ q ∧ p :=

⟨ fun h => ⟨h.right, h.left⟩, fun h => ⟨h.right, h.left⟩ ⟩

example (h : p ∧ q) : q ∧ p := (and_swap p q).mp h

引入辅助子目标

这里介绍Lean提供的另一种帮助构造长证明的方法,即have结构,它在证明中引入了一个辅助的子目标。下面是一个小例子,改编自上一节:

variable (p q : Prop)

example (h : p ∧ q) : q ∧ p :=

have hp : p := h.left

have hq : q := h.right

show q ∧ p from And.intro hq hp

在内部,表达式have h : p := s; t产生项(fun (h : p) => t) s。换句话说,s是p的证明,t是假设h : p的期望结论的证明,并且这两个是由lambda抽象和应用组合在一起的。这个简单的方法在构建长证明时非常有用,因为我们可以使用中间的have作为通向最终目标的垫脚石。

Lean还支持从目标向后推理的结构化方法,它模仿了普通数学文献中“足以说明某某”(suffices to show)的构造。下一个例子简单地排列了前面证明中的最后两行。

variable (p q : Prop)

example (h : p ∧ q) : q ∧ p :=

have hp : p := h.left

suffices hq : q from And.intro hq hp

show q from And.right h

suffices hq : q给出了两条目标。第一,我们需要证明,通过利用附加假设hq : q证明原目标q ∧ p,这样足以证明q,第二,我们需要证明q。

经典逻辑

到目前为止,我们看到的引入和消去规则都是构造主义的,也就是说,它们反映了基于命题即类型对应的逻辑连接词的计算理解。普通经典逻辑在此基础上加上了排中律p ∨ ¬p(excluded middle, em)。要使用这个原则,你必须打开经典逻辑命名空间。

open Classical

variable (p : Prop)

#check em p

从直觉上看,构造主义的“或”非常强:断言p ∨ q等于知道哪个是真实情况。如果RH代表黎曼猜想,经典数学家愿意断言RH ∨ ¬RH,即使我们还不能断言析取式的任何一端。

排中律的一个结果是双重否定消去规则(double-negation elimination, dne):

open Classical

theorem dne {p : Prop} (h : ¬¬p) : p :=

Or.elim (em p)

(fun hp : p => hp)

(fun hnp : ¬p => absurd hnp h)

双重否定消去规则给出了一种证明任何命题p的方法:通过假设¬p来推导出false,相当于证明了p。换句话说,双重否定消除允许反证法,这在构造主义逻辑中通常是不可能的。作为练习,你可以试着证明相反的情况,也就是说,证明em可以由dne证明。

经典公理还可以通过使用em让你获得额外的证明模式。例如,我们可以逐情况进行证明:

open Classical

variable (p : Prop)

example (h : ¬¬p) : p :=

byCases

(fun h1 : p => h1)

(fun h1 : ¬p => absurd h1 h)

或者你可以用反证法来证明:

open Classical

variable (p : Prop)

example (h : ¬¬p) : p :=

byContradiction

(fun h1 : ¬p =>

show False from h h1)

如果你不习惯构造主义,你可能需要一些时间来了解经典推理在哪里使用。在下面的例子中,它是必要的,因为从一个构造主义的观点来看,知道p和q不同时真并不一定告诉你哪一个是假的:

open Classical

variable (p q : Prop)

-- BEGIN

example (h : ¬(p ∧ q)) : ¬p ∨ ¬q :=

Or.elim (em p)

(fun hp : p =>

Or.inr

(show ¬q from

fun hq : q =>

h ⟨hp, hq⟩))

(fun hp : ¬p =>

Or.inl hp)

稍后我们将看到,构造逻辑中有某些情况允许“排中律”和“双重否定消除律”等,而Lean支持在这种情况下使用经典推理,而不依赖于排中律。

Lean中使用的公理的完整列表见公理与计算。

逻辑命题的例子

Lean的标准库包含了许多命题逻辑的有效语句的证明,你可以自由地在自己的证明中使用这些证明。下面的列表包括一些常见的逻辑等价式。

交换律:

p ∧ q ↔ q ∧ pp ∨ q ↔ q ∨ p

结合律:

(p ∧ q) ∧ r ↔ p ∧ (q ∧ r)(p ∨ q) ∨ r ↔ p ∨ (q ∨ r)

分配律:

p ∧ (q ∨ r) ↔ (p ∧ q) ∨ (p ∧ r)p ∨ (q ∧ r) ↔ (p ∨ q) ∧ (p ∨ r)

其他性质:

(p → (q → r)) ↔ (p ∧ q → r)((p ∨ q) → r) ↔ (p → r) ∧ (q → r)¬(p ∨ q) ↔ ¬p ∧ ¬q¬p ∨ ¬q → ¬(p ∧ q)¬(p ∧ ¬p)p ∧ ¬q → ¬(p → q)¬p → (p → q)(¬p ∨ q) → (p → q)p ∨ False ↔ pp ∧ False ↔ False¬(p ↔ ¬p)(p → q) → (¬q → ¬p)

经典推理:

(p → r ∨ s) → ((p → r) ∨ (p → s))¬(p ∧ q) → ¬p ∨ ¬q¬(p → q) → p ∧ ¬q(p → q) → (¬p ∨ q)(¬q → ¬p) → (p → q)p ∨ ¬p(((p → q) → p) → p)

sorry标识符神奇地生成任何东西的证明,或者提供任何数据类型的对象。当然,作为一种证明方法,它是不可靠的——例如,你可以使用它来证明False——并且当文件使用或导入依赖于它的定理时,Lean会产生严重的警告。但它对于增量地构建长证明非常有用。从上到下写证明,用sorry来填子证明。确保Lean接受所有的sorry;如果不是,则有一些错误需要纠正。然后返回,用实际的证据替换每个sorry,直到做完。

有另一个有用的技巧。你可以使用下划线_作为占位符,而不是sorry。回想一下,这告诉Lean该参数是隐式的,应该自动填充。如果Lean尝试这样做并失败了,它将返回一条错误消息“不知道如何合成占位符”(Don't know how to synthesize placeholder),然后是它所期望的项的类型,以及上下文中可用的所有对象和假设。换句话说,对于每个未解决的占位符,Lean报告在那一点上需要填充的子目标。然后,你可以通过递增填充这些占位符来构造一个证明。

这里有两个简单的证明例子作为参考。

open Classical

-- 分配律

example (p q r : Prop) : p ∧ (q ∨ r) ↔ (p ∧ q) ∨ (p ∧ r) :=

Iff.intro

(fun h : p ∧ (q ∨ r) =>

have hp : p := h.left

Or.elim (h.right)

(fun hq : q =>

show (p ∧ q) ∨ (p ∧ r) from Or.inl ⟨hp, hq⟩)

(fun hr : r =>

show (p ∧ q) ∨ (p ∧ r) from Or.inr ⟨hp, hr⟩))

(fun h : (p ∧ q) ∨ (p ∧ r) =>

Or.elim h

(fun hpq : p ∧ q =>

have hp : p := hpq.left

have hq : q := hpq.right

show p ∧ (q ∨ r) from ⟨hp, Or.inl hq⟩)

(fun hpr : p ∧ r =>

have hp : p := hpr.left

have hr : r := hpr.right

show p ∧ (q ∨ r) from ⟨hp, Or.inr hr⟩))

-- 需要一点经典推理的例子

example (p q : Prop) : ¬(p ∧ ¬q) → (p → q) :=

fun h : ¬(p ∧ ¬q) =>

fun hp : p =>

show q from

Or.elim (em q)

(fun hq : q => hq)

(fun hnq : ¬q => absurd (And.intro hp hnq) h)

练习

证明以下等式,用真实证明取代“sorry”占位符。

variable (p q r : Prop)

-- ∧ 和 ∨ 的交换律

example : p ∧ q ↔ q ∧ p := sorry

example : p ∨ q ↔ q ∨ p := sorry

-- ∧ 和 ∨ 的结合律

example : (p ∧ q) ∧ r ↔ p ∧ (q ∧ r) := sorry

example : (p ∨ q) ∨ r ↔ p ∨ (q ∨ r) := sorry

-- 分配律

example : p ∧ (q ∨ r) ↔ (p ∧ q) ∨ (p ∧ r) := sorry

example : p ∨ (q ∧ r) ↔ (p ∨ q) ∧ (p ∨ r) := sorry

-- 其他性质

example : (p → (q → r)) ↔ (p ∧ q → r) := sorry

example : ((p ∨ q) → r) ↔ (p → r) ∧ (q → r) := sorry

example : ¬(p ∨ q) ↔ ¬p ∧ ¬q := sorry

example : ¬p ∨ ¬q → ¬(p ∧ q) := sorry

example : ¬(p ∧ ¬p) := sorry

example : p ∧ ¬q → ¬(p → q) := sorry

example : ¬p → (p → q) := sorry

example : (¬p ∨ q) → (p → q) := sorry

example : p ∨ False ↔ p := sorry

example : p ∧ False ↔ False := sorry

example : (p → q) → (¬q → ¬p) := sorry

证明以下等式,用真实证明取代“sorry”占位符。这里需要一点经典逻辑。

open Classical

variable (p q r s : Prop)

example : (p → r ∨ s) → ((p → r) ∨ (p → s)) := sorry

example : ¬(p ∧ q) → ¬p ∨ ¬q := sorry

example : ¬(p → q) → p ∧ ¬q := sorry

example : (p → q) → (¬p ∨ q) := sorry

example : (¬q → ¬p) → (p → q) := sorry

example : p ∨ ¬p := sorry

example : (((p → q) → p) → p) := sorry

证明¬(p ↔ ¬p)且不使用经典逻辑。

量词与等价

上一章介绍了构造包含命题连接词的证明方法。在本章中,我们扩展逻辑结构,包括全称量词和存在量词,以及等价关系。

全称量词

如果α是任何类型,我们可以将α上的一元谓词p作为α → Prop类型的对象。在这种情况下,给定x : α, p x表示断言p在x上成立。类似地,一个对象r : α → α → Prop表示α上的二元关系:给定x y : α,r x y表示断言x与y相关。

全称量词∀ x : α, p x表示,对于每一个x : α,p x成立。与命题连接词一样,在自然演绎系统中,“forall”有引入和消去规则。非正式地,引入规则是:

给定

p x的证明,在x : α是任意的情况下,我们得到∀ x : α, p x的证明。

消去规则是:

给定

∀ x : α, p x的证明和任何项t : α,我们得到p t的证明。

与蕴含的情况一样,命题即类型。回想依值箭头类型的引入规则:

给定类型为

β x的项t,在x : α是任意的情况下,我们有(fun x : α => t) : (x : α) → β x。

消去规则:

给定项

s : (x : α) → β x和任何项t : α,我们有s t : β t。

在p x具有Prop类型的情况下,如果我们用∀ x : α, p x替换(x : α) → β x,就得到构建涉及全称量词的证明的规则。

因此,构造演算用全称表达式来识别依值箭头类型。如果p是任何表达式,∀ x : α, p不过是(x : α) → p的替代符号,在p是命题的情况下,前者比后者更自然。通常,表达式p取决于x : α。回想一下,在普通函数空间中,我们可以将α → β解释为(x : α) → β的特殊情况,其中β不依赖于x。类似地,我们可以把命题之间的蕴涵p → q看作是∀ x : p, q的特殊情况,其中q不依赖于x。

下面是一个例子,说明了如何运用命题即类型对应规则。∀可以用\forall输入,也可以用前两个字母简写\fo。

example (α : Type) (p q : α → Prop) : (∀ x : α, p x ∧ q x) → ∀ y : α, p y :=

fun h : ∀ x : α, p x ∧ q x =>

fun y : α =>

show p y from (h y).left

作为一种符号约定,我们给予全称量词尽可能最宽的优先级范围,因此上面例子中的假设中,需要用括号将x上的量词限制起来。证明∀ y : α, p y的标准方法是取任意的y,然后证明p y。这是引入规则。现在,给定h有类型∀ x : α, p x ∧ q x,表达式h y有类型p y ∧ q y。这是消去规则。取合取的左侧得到想要的结论p y。

只有约束变量名称不同的表达式被认为是等价的。因此,例如,我们可以在假设和结论中使用相同的变量x,并在证明中用不同的变量z实例化它:

example (α : Type) (p q : α → Prop) : (∀ x : α, p x ∧ q x) → ∀ x : α, p x :=

fun h : ∀ x : α, p x ∧ q x =>

fun z : α =>

show p z from And.left (h z)

再举一个例子,下面是关系r的传递性:

variable (α : Type) (r : α → α → Prop)

variable (trans_r : ∀ x y z, r x y → r y z → r x z)

variable (a b c : α)

variable (hab : r a b) (hbc : r b c)

#check trans_r -- ∀ (x y z : α), r x y → r y z → r x z

#check trans_r a b c

#check trans_r a b c hab

#check trans_r a b c hab hbc

当我们在值a b c上实例化trans_r时,我们最终得到r a b → r b c → r a c的证明。将此应用于“假设”hab : r a b,我们得到了r b c → r a c的一个证明。最后将它应用到假设hbc中,得到结论r a c的证明。

variable (α : Type) (r : α → α → Prop)

variable (trans_r : ∀ {x y z}, r x y → r y z → r x z)

variable (a b c : α)

variable (hab : r a b) (hbc : r b c)

#check trans_r

#check trans_r hab

#check trans_r hab hbc

优点是我们可以简单地写trans_r hab hbc作为r a c的证明。一个缺点是Lean没有足够的信息来推断表达式trans_r和trans_r hab中的参数类型。第一个#check命令的输出是r ?m.1 ?m.2 → r ?m.2 ?m.3 → r ?m.1 ?m.3,表示在本例中隐式参数未指定。

下面是一个用等价关系进行基本推理的例子:

variable (α : Type) (r : α → α → Prop)

variable (refl_r : ∀ x, r x x)

variable (symm_r : ∀ {x y}, r x y → r y x)

variable (trans_r : ∀ {x y z}, r x y → r y z → r x z)

example (a b c d : α) (hab : r a b) (hcb : r c b) (hcd : r c d) : r a d :=

trans_r (trans_r hab (symm_r hcb)) hcd

为了习惯使用全称量词,你应该尝试本节末尾的一些练习。

依值箭头类型的类型规则,特别是全称量词,体现了Prop命题类型与其他对象的类型的不同。假设我们有α : Sort i和β : Sort j,其中表达式β可能依赖于变量x : α。那么(x : α) → β是Sort (imax i j)的一个元素,其中imax i j是i和j在j不为0时的最大值,否则为0。

其想法如下。如果j不是0,然后(x : α) → β是Sort (max i j)类型的一个元素。换句话说,从α到β的一类依值函数存在于指数为i和j最大值的宇宙中。然而,假设β属于Sort 0,即Prop的一个元素。在这种情况下,(x : α) → β也是Sort 0的一个元素,无论α生活在哪种类型的宇宙中。换句话说,如果β是一个依赖于α的命题,那么∀ x : α, β又是一个命题。这反映出Prop作为一种命题类型而不是数据类型,这也使得Prop具有“非直谓性”(impredicative)。

“直谓性”一词起源于20世纪初的数学基础发展,当时逻辑学家如庞加莱和罗素将集合论的悖论归咎于“恶性循环”:当我们通过量化一个集合来定义一个属性时,这个集合包含了被定义的属性。注意,如果α是任何类型,我们可以在α上形成所有谓词的类型α → Prop(α的“幂”类型)。Prop的非直谓性意味着我们可以通过α → Prop形成量化命题。特别是,我们可以通过量化所有关于α的谓词来定义α上的谓词,这正是曾经被认为有问题的循环类型。

等价

现在让我们来看看在Lean库中定义的最基本的关系之一,即等价关系。在归纳类型一章中,我们将解释如何从Lean的逻辑框架中定义等价。在这里我们解释如何使用它。

等价关系的基本性质:反身性、对称性、传递性。

#check Eq.refl -- ∀ (a : ?m.1), a = a

#check Eq.symm -- ?m.2 = ?m.3 → ?m.3 = ?m.2

#check Eq.trans -- ?m.2 = ?m.3 → ?m.3 = ?m.4 → ?m.2 = ?m.4

通过告诉Lean不要插入隐参数(在这里显示为元变量)可以使输出更容易阅读。

universe u

#check @Eq.refl.{u} -- ∀ {α : Sort u} (a : α), a = a

#check @Eq.symm.{u} -- ∀ {α : Sort u} {a b : α}, a = b → b = a

#check @Eq.trans.{u} -- ∀ {α : Sort u} {a b c : α}, a = b → b = c → a = c

.{u}告诉Lean实例化宇宙u上的常量。

因此,我们可以将上一节中的示例具体化为等价关系:

variable (α : Type) (a b c d : α)

variable (hab : a = b) (hcb : c = b) (hcd : c = d)

example : a = d :=

Eq.trans (Eq.trans hab (Eq.symm hcb)) hcd

我们也可以使用简写:

example : a = d := (hab.trans hcb.symm).trans hcd

反身性比它看上去更强大。回想一下,在构造演算中,项有一个计算解释,可化简为相同形式的项会被逻辑框架视为相同的。因此,一些非平凡的恒等式可以通过自反性来证明:

variable (α β : Type)

example (f : α → β) (a : α) : (fun x => f x) a = f a := Eq.refl _

example (a : α) (b : α) : (a, b).1 = a := Eq.refl _

example : 2 + 3 = 5 := Eq.refl _

框架的这个特性非常重要,以至于库中为Eq.refl _专门定义了一个符号rfl:

variable (α β : Type)

example (f : α → β) (a : α) : (fun x => f x) a = f a := rfl

example (a : α) (b : α) : (a, b).1 = a := rfl

example : 2 + 3 = 5 := rfl

然而,等价不仅仅是一种关系。它有一个重要的性质,即每个断言都遵从等价性,即我们可以在不改变真值的情况下对表达式做等价代换。也就是说,给定h1 : a = b和h2 : p a,我们可以构造一个证明p b,只需要使用代换Eq.subst h1 h2。

example (α : Type) (a b : α) (p : α → Prop)

(h1 : a = b) (h2 : p a) : p b :=

Eq.subst h1 h2

example (α : Type) (a b : α) (p : α → Prop)

(h1 : a = b) (h2 : p a) : p b :=

h1 ▸ h2

第二个例子中的三角形是建立在Eq.subst和Eq.symm之上的宏,它可以通过\t来输入。

规则Eq.subst定义了一些辅助规则,用来执行更显式的替换。它们是为处理应用型项,即形式为s t的项而设计的。这些辅助规则是,使用congrArg来替换参数,使用congrFun来替换正在应用的项,并且可以同时使用congr来替换两者。

variable (α : Type)

variable (a b : α)

variable (f g : α → Nat)

variable (h₁ : a = b)

variable (h₂ : f = g)

example : f a = f b := congrArg f h₁

example : f a = g a := congrFun h₂ a

example : f a = g b := congr h₂ h₁

Lean的库包含大量通用的等式,例如:

variable (a b c d : Nat)

example : a + 0 = a := Nat.add_zero a

example : 0 + a = a := Nat.zero_add a

example : a * 1 = a := Nat.mul_one a

example : 1 * a = a := Nat.one_mul a

example : a + b = b + a := Nat.add_comm a b

example : a + b + c = a + (b + c) := Nat.add_assoc a b c

example : a * b = b * a := Nat.mul_comm a b

example : a * b * c = a * (b * c) := Nat.mul_assoc a b c

example : a * (b + c) = a * b + a * c := Nat.mul_add a b c

example : a * (b + c) = a * b + a * c := Nat.left_distrib a b c

example : (a + b) * c = a * c + b * c := Nat.add_mul a b c

example : (a + b) * c = a * c + b * c := Nat.right_distrib a b c

Nat.mul_add和Nat.add_mul是Nat.left_distrib和Nat.right_distrib的代称。上面的属性是为自然数类型Nat声明的。

这是一个使用代换以及结合律、交换律和分配律的自然数计算的例子。

example (x y z : Nat) : x * (y + z) = x * y + x * z := Nat.mul_add x y z

example (x y z : Nat) : (x + y) * z = x * z + y * z := Nat.add_mul x y z

example (x y z : Nat) : x + y + z = x + (y + z) := Nat.add_assoc x y z

example (x y : Nat) : (x + y) * (x + y) = x * x + y * x + x * y + y * y :=

have h1 : (x + y) * (x + y) = (x + y) * x + (x + y) * y :=

Nat.mul_add (x + y) x y

have h2 : (x + y) * (x + y) = x * x + y * x + (x * y + y * y) :=

(Nat.add_mul x y x) ▸ (Nat.add_mul x y y) ▸ h1

h2.trans (Nat.add_assoc (x * x + y * x) (x * y) (y * y)).symm

注意,Eq.subst的第二个隐式参数提供了将要发生代换的表达式上下文,其类型为α → Prop。因此,推断这个谓词需要一个高阶合一(higher-order unification)的实例。一般来说,确定高阶合一器是否存在的问题是无法确定的,而Lean充其量只能提供不完美的和近似的解决方案。因此,Eq.subst并不总是做你想要它做的事。宏h ▸ e使用了更有效的启发式方法来计算这个隐参数,并且在不能应用Eq.subst的情况下通常会成功。

因为等式推理是如此普遍和重要,Lean提供了许多机制来更有效地执行它。下一节将提供允许你以更自然和清晰的方式编写计算式证明的语法。但更重要的是,等式推理是由项重写器、简化器和其他种类的自动化方法支持的。术语重写器和简化器将在下一节中简要描述,然后在下一章中更详细地描述。

计算式证明

一个计算式证明是指一串使用诸如等式的传递性等基本规则得到的中间结果。在Lean中,计算式证明从关键字calc开始,语法如下:

calc

<expr>_0 'op_1' <expr>_1 ':=' <proof>_1

'_' 'op_2' <expr>_2 ':=' <proof>_2

...

'_' 'op_n' <expr>_n ':=' <proof>_n

每个<proof>_i是<expr>_{i-1} op_i <expr>_i的证明。

例子:

variable (a b c d e : Nat)

variable (h1 : a = b)

variable (h2 : b = c + 1)

variable (h3 : c = d)

variable (h4 : e = 1 + d)

theorem T : a = e :=

calc

a = b := h1

_ = c + 1 := h2

_ = d + 1 := congrArg Nat.succ h3

_ = 1 + d := Nat.add_comm d 1

_ = e := Eq.symm h4

这种写证明的风格在与simp和rewrite策略(tactic)结合使用时最为有效,这些策略将在下一章详细讨论。例如,用缩写`rw'表示重写,上面的证明可以写成如下。

theorem T : a = e :=

calc

a = b := by rw [h1]

_ = c + 1 := by rw [h2]

_ = d + 1 := by rw [h3]

_ = 1 + d := by rw [Nat.add_comm]

_ = e := by rw [h4]

本质上,rw策略使用一个给定的等式(它可以是一个假设、一个定理名称或一个复杂的项)来“重写”目标。如果这样做将目标简化为一种等式t = t,那么该策略将使用反身性来证明这一点。

重写可以一次应用一系列,因此上面的证明可以缩写为:

theorem T : a = e :=

calc

a = d + 1 := by rw [h1, h2, h3]

_ = 1 + d := by rw [Nat.add_comm]

_ = e := by rw [h4]

甚至这样:

theorem T : a = e :=

by rw [h1, h2, h3, Nat.add_comm, h4]

相反,simp策略通过在项中以任意顺序在任何适用的地方重复应用给定的等式来重写目标。它还使用了之前声明给系统的其他规则,并明智地应用交换性以避免循环。因此,我们也可以如下证明定理:

theorem T : a = e :=

by simp [h1, h2, h3, Nat.add_comm, h4]

我们将在下一章讨论rw和simp的变体。

calc命令可以配置为任何支持某种形式的传递性的关系。它甚至可以结合不同的关系。

example (a b c d : Nat) (h1 : a = b) (h2 : b ≤ c) (h3 : c + 1 < d) : a < d :=

calc

a = b := h1

_ < b + 1 := Nat.lt_succ_self b

_ ≤ c + 1 := Nat.succ_le_succ h2

_ < d := h3

使用calc,我们可以以一种更自然、更清晰的方式写出上一节的证明。

example (x y : Nat) : (x + y) * (x + y) = x * x + y * x + x * y + y * y :=

calc

(x + y) * (x + y) = (x + y) * x + (x + y) * y := by rw [Nat.mul_add]

_ = x * x + y * x + (x + y) * y := by rw [Nat.add_mul]

_ = x * x + y * x + (x * y + y * y) := by rw [Nat.add_mul]

_ = x * x + y * x + x * y + y * y := by rw [←Nat.add_assoc]

Nat.add_assoc之前的左箭头指挥重写以相反的方向使用等式。(你可以输入\l或ascii码<-。)如果追求简洁,rw和simp可以一次性完成这项工作:

example (x y : Nat) : (x + y) * (x + y) = x * x + y * x + x * y + y * y :=

by rw [Nat.mul_add, Nat.add_mul, Nat.add_mul, ←Nat.add_assoc]

example (x y : Nat) : (x + y) * (x + y) = x * x + y * x + x * y + y * y :=

by simp [Nat.mul_add, Nat.add_mul, Nat.add_assoc, Nat.add_left_comm]

存在量词

存在量词可以写成exists x : α, p x或∃ x : α, p x。这两个写法实际上在Lean的库中的定义为一个更冗长的表达式,Exists (fun x : α => p x)。

存在量词也有一个引入规则和一个消去规则。引入规则很简单:要证明∃ x : α, p x,只需提供一个合适的项t和对p t的证明即可。∃用\exists或简写\ex输入,下面是一些例子:

example : ∃ x : Nat, x > 0 :=

have h : 1 > 0 := Nat.zero_lt_succ 0

Exists.intro 1 h

example (x : Nat) (h : x > 0) : ∃ y, y < x :=

Exists.intro 0 h

example (x y z : Nat) (hxy : x < y) (hyz : y < z) : ∃ w, x < w ∧ w < z :=

Exists.intro y (And.intro hxy hyz)

#check @Exists.intro

当类型可从上下文中推断时,我们可以使用匿名构造子表示法⟨t, h⟩替换Exists.intro t h。

example : ∃ x : Nat, x > 0 :=

have h : 1 > 0 := Nat.zero_lt_succ 0

⟨1, h⟩

example (x : Nat) (h : x > 0) : ∃ y, y < x :=

⟨0, h⟩

example (x y z : Nat) (hxy : x < y) (hyz : y < z) : ∃ w, x < w ∧ w < z :=

⟨y, hxy, hyz⟩

注意Exists.intro有隐参数:Lean必须在结论∃ x, p x中推断谓词p : α → Prop。这不是一件小事。例如,如果我们有hg : g 0 0 = 0和Exists.intro 0 hg,有许多可能的值的谓词p,对应定理∃ x, g x x = x,∃ x, g x x = 0,∃ x, g x 0 = x,等等。Lean使用上下文来推断哪个是合适的。下面的例子说明了这一点,在这个例子中,我们设置了选项pp.explicit为true,要求Lean打印隐参数。

variable (g : Nat → Nat → Nat)

variable (hg : g 0 0 = 0)

theorem gex1 : ∃ x, g x x = x := ⟨0, hg⟩

theorem gex2 : ∃ x, g x 0 = x := ⟨0, hg⟩

theorem gex3 : ∃ x, g 0 0 = x := ⟨0, hg⟩

theorem gex4 : ∃ x, g x x = 0 := ⟨0, hg⟩

set_option pp.explicit true -- 打印隐参数

#print gex1

#print gex2

#print gex3

#print gex4

我们可以将Exists.intro视为信息隐藏操作,因为它将断言的具体实例隐藏起来变成了存在量词。存在消去规则Exists.elim执行相反的操作。它允许我们从∃ x : α, p x证明一个命题q,通过证明对于任意值w时p w都能推出q。粗略地说,既然我们知道有一个x满足p x,我们可以给它起个名字,比如w。如果q没有提到w,那么表明p w能推出q就等同于表明q从任何这样的x的存在而推得。下面是一个例子:

variable (α : Type) (p q : α → Prop)

example (h : ∃ x, p x ∧ q x) : ∃ x, q x ∧ p x :=

Exists.elim h

(fun w =>

fun hw : p w ∧ q w =>

show ∃ x, q x ∧ p x from ⟨w, hw.right, hw.left⟩)

把存在消去规则和析取消去规则作个比较可能会带来一些启发。命题∃ x : α, p x可以看成一个对所有α中的元素a所组成的命题p a的大型析取。注意到匿名构造子⟨w, hw.right, hw.left⟩是嵌套的构造子⟨w, ⟨hw.right, hw.left⟩⟩的缩写。

存在式命题类型很像依值类型一节所述的sigma类型。给定a : α和h : p a时,项Exists.intro a h具有类型(∃ x : α, p x) : Prop,而Sigma.mk a h具有类型(Σ x : α, p x) : Type。∃和Σ之间的相似性是Curry-Howard同构的另一例子。

Lean提供一个更加方便的消去存在量词的途径,那就是通过match表达式。

variable (α : Type) (p q : α → Prop)

example (h : ∃ x, p x ∧ q x) : ∃ x, q x ∧ p x :=

match h with

| ⟨w, hw⟩ => ⟨w, hw.right, hw.left⟩

match表达式是Lean功能定义系统的一部分,它提供了复杂功能的方便且丰富的表达方式。再一次,正是Curry-Howard同构让我们能够采用这种机制来编写证明。match语句将存在断言“析构”到组件w和hw中,然后可以在语句体中使用它们来证明命题。我们可以对match中使用的类型进行注释,以提高清晰度:

# variable (α : Type) (p q : α → Prop)

example (h : ∃ x, p x ∧ q x) : ∃ x, q x ∧ p x :=

match h with

| ⟨(w : α), (hw : p w ∧ q w)⟩ => ⟨w, hw.right, hw.left⟩

我们甚至可以同时使用match语句来分解合取:

# variable (α : Type) (p q : α → Prop)

example (h : ∃ x, p x ∧ q x) : ∃ x, q x ∧ p x :=

match h with

| ⟨w, hpw, hqw⟩ => ⟨w, hqw, hpw⟩

Lean还提供了一个模式匹配的let表达式:

# variable (α : Type) (p q : α → Prop)

example (h : ∃ x, p x ∧ q x) : ∃ x, q x ∧ p x :=

let ⟨w, hpw, hqw⟩ := h

⟨w, hqw, hpw⟩

这实际上是上面的match结构的替代表示法。Lean甚至允许我们在fun表达式中使用隐含的match:

# variable (α : Type) (p q : α → Prop)

example : (∃ x, p x ∧ q x) → ∃ x, q x ∧ p x :=

fun ⟨w, hpw, hqw⟩ => ⟨w, hqw, hpw⟩

我们将在归纳和递归一章看到所有这些变体都是更一般的模式匹配构造的实例。

在下面的例子中,我们将even a定义为∃ b, a = 2*b,然后我们证明两个偶数的和是偶数。

def is_even (a : Nat) := ∃ b, a = 2 * b

theorem even_plus_even (h1 : is_even a) (h2 : is_even b) : is_even (a + b) :=

Exists.elim h1 (fun w1 (hw1 : a = 2 * w1) =>

Exists.elim h2 (fun w2 (hw2 : b = 2 * w2) =>

Exists.intro (w1 + w2)

(calc

a + b = 2 * w1 + 2 * w2 := by rw [hw1, hw2]

_ = 2*(w1 + w2) := by rw [Nat.mul_add])))

使用本章描述的各种小工具——match语句、匿名构造子和rewrite策略,我们可以简洁地写出如下证明:

def is_even (a : Nat) := ∃ b, a = 2 * b

theorem even_plus_even (h1 : is_even a) (h2 : is_even b) : is_even (a + b) :=

match h1, h2 with

| ⟨w1, hw1⟩, ⟨w2, hw2⟩ => ⟨w1 + w2, by rw [hw1, hw2, Nat.mul_add]⟩

就像构造主义的“或”比古典的“或”强,同样,构造的“存在”也比古典的“存在”强。例如,下面的推论需要经典推理,因为从构造的角度来看,知道并不是每一个x都满足¬ p,并不等于有一个特定的x满足p。

open Classical

variable (p : α → Prop)

example (h : ¬ ∀ x, ¬ p x) : ∃ x, p x :=

byContradiction

(fun h1 : ¬ ∃ x, p x =>

have h2 : ∀ x, ¬ p x :=

fun x =>

fun h3 : p x =>

have h4 : ∃ x, p x := ⟨x, h3⟩

show False from h1 h4

show False from h h2)

下面是一些涉及存在量词的常见等式。在下面的练习中,我们鼓励你尽可能多写出证明。你需要判断哪些是非构造主义的,因此需要一些经典推理。

open Classical

variable (α : Type) (p q : α → Prop)

variable (r : Prop)

example : (∃ x : α, r) → r := sorry

example (a : α) : r → (∃ x : α, r) := sorry

example : (∃ x, p x ∧ r) ↔ (∃ x, p x) ∧ r := sorry

example : (∃ x, p x ∨ q x) ↔ (∃ x, p x) ∨ (∃ x, q x) := sorry

example : (∀ x, p x) ↔ ¬ (∃ x, ¬ p x) := sorry

example : (∃ x, p x) ↔ ¬ (∀ x, ¬ p x) := sorry

example : (¬ ∃ x, p x) ↔ (∀ x, ¬ p x) := sorry

example : (¬ ∀ x, p x) ↔ (∃ x, ¬ p x) := sorry

example : (∀ x, p x → r) ↔ (∃ x, p x) → r := sorry

example (a : α) : (∃ x, p x → r) ↔ (∀ x, p x) → r := sorry

example (a : α) : (∃ x, r → p x) ↔ (r → ∃ x, p x) := sorry

注意,第二个例子和最后两个例子要求假设至少有一个类型为α的元素a。

以下是两个比较困难的问题的解:

open Classical

variable (α : Type) (p q : α → Prop)

variable (a : α)

variable (r : Prop)

example : (∃ x, p x ∨ q x) ↔ (∃ x, p x) ∨ (∃ x, q x) :=

Iff.intro

(fun ⟨a, (h1 : p a ∨ q a)⟩ =>

Or.elim h1

(fun hpa : p a => Or.inl ⟨a, hpa⟩)

(fun hqa : q a => Or.inr ⟨a, hqa⟩))

(fun h : (∃ x, p x) ∨ (∃ x, q x) =>

Or.elim h

(fun ⟨a, hpa⟩ => ⟨a, (Or.inl hpa)⟩)

(fun ⟨a, hqa⟩ => ⟨a, (Or.inr hqa)⟩))

example : (∃ x, p x → r) ↔ (∀ x, p x) → r :=

Iff.intro

(fun ⟨b, (hb : p b → r)⟩ =>

fun h2 : ∀ x, p x =>

show r from hb (h2 b))

(fun h1 : (∀ x, p x) → r =>

show ∃ x, p x → r from

byCases

(fun hap : ∀ x, p x => ⟨a, λ h' => h1 hap⟩)

(fun hnap : ¬ ∀ x, p x =>

byContradiction

(fun hnex : ¬ ∃ x, p x → r =>

have hap : ∀ x, p x :=

fun x =>

byContradiction

(fun hnp : ¬ p x =>

have hex : ∃ x, p x → r := ⟨x, (fun hp => absurd hp hnp)⟩

show False from hnex hex)

show False from hnap hap)))

更多证明语言

我们已经看到像fun、have和show这样的关键字使得写出反映非正式数学证明结构的正式证明项成为可能。在本节中,我们将讨论证明语言的一些通常很方便的附加特性。

首先,我们可以使用匿名的have表达式来引入一个辅助目标,而不需要标注它。我们可以使用关键字this'来引用最后一个以这种方式引入的表达式:

variable (f : Nat → Nat)

variable (h : ∀ x : Nat, f x ≤ f (x + 1))

example : f 0 ≤ f 3 :=

have : f 0 ≤ f 1 := h 0

have : f 0 ≤ f 2 := Nat.le_trans this (h 1)

show f 0 ≤ f 3 from Nat.le_trans this (h 2)

通常证明从一个事实转移到另一个事实,所以这可以有效地消除杂乱的大量标签。

当目标可以推断出来时,我们也可以让Lean写by assumption来填写证明:

# variable (f : Nat → Nat)

# variable (h : ∀ x : Nat, f x ≤ f (x + 1))

example : f 0 ≤ f 3 :=

have : f 0 ≤ f 1 := h 0

have : f 0 ≤ f 2 := Nat.le_trans (by assumption) (h 1)

show f 0 ≤ f 3 from Nat.le_trans (by assumption) (h 2)

这告诉Lean使用assumption策略,反过来,通过在局部上下文中找到合适的假设来证明目标。我们将在下一章学习更多关于assumption策略的内容。

我们也可以通过写‹p›的形式要求Lean填写证明,其中p是我们希望Lean在上下文中找到的证明命题。你可以分别使用\f<和\f>输入这些角引号。字母“f”表示“French”,因为unicode符号也可以用作法语引号。事实上,这个符号在Lean中定义如下:

notation "‹" p "›" => show p by assumption

这种方法比使用by assumption更稳健,因为需要推断的假设类型是显式给出的。它还使证明更具可读性。这里有一个更详细的例子:

variable (f : Nat → Nat)

variable (h : ∀ x : Nat, f x ≤ f (x + 1))

example : f 0 ≥ f 1 → f 1 ≥ f 2 → f 0 = f 2 :=

fun _ : f 0 ≥ f 1 =>

fun _ : f 1 ≥ f 2 =>

have : f 0 ≥ f 2 := Nat.le_trans ‹f 1 ≥ f 2› ‹f 0 ≥ f 1›

have : f 0 ≤ f 2 := Nat.le_trans (h 0) (h 1)

show f 0 = f 2 from Nat.le_antisymm this ‹f 0 ≥ f 2›

你可以这样使用法语引号来指代上下文中的“任何东西”,而不仅仅是匿名引入的东西。它的使用也不局限于命题,尽管将它用于数据有点奇怪:

example (n : Nat) : Nat := ‹Nat›

稍后,我们将展示如何使用Lean中的宏系统扩展证明语言。

练习

- 证明以下等式:

variable (α : Type) (p q : α → Prop)

example : (∀ x, p x ∧ q x) ↔ (∀ x, p x) ∧ (∀ x, q x) := sorry

example : (∀ x, p x → q x) → (∀ x, p x) → (∀ x, q x) := sorry

example : (∀ x, p x) ∨ (∀ x, q x) → ∀ x, p x ∨ q x := sorry

你还应该想想为什么在最后一个例子中反过来是不能证明的。

- 当一个公式的组成部分不依赖于被全称的变量时,通常可以把它提取出一个全称量词的范围。尝试证明这些(第二个命题中的一个方向需要经典逻辑):

variable (α : Type) (p q : α → Prop)

variable (r : Prop)

example : α → ((∀ x : α, r) ↔ r) := sorry

example : (∀ x, p x ∨ r) ↔ (∀ x, p x) ∨ r := sorry

example : (∀ x, r → p x) ↔ (r → ∀ x, p x) := sorry

- 考虑“理发师悖论”:在一个小镇里,这里有一个(男性)理发师给所有不为自己刮胡子的人刮胡子。证明这里存在矛盾:

variable (men : Type) (barber : men)

variable (shaves : men → men → Prop)

example (h : ∀ x : men, shaves barber x ↔ ¬ shaves x x) : false := sorry

- 如果没有任何参数,类型

Prop的表达式只是一个断言。填入下面prime和Fermat_prime的定义,并构造每个给定的断言。例如,通过断言每个自然数n都有一个大于n的质数,你可以说有无限多个质数。哥德巴赫弱猜想指出,每一个大于5的奇数都是三个素数的和。如果有必要,请查阅费马素数的定义或其他任何资料。

def even (n : Nat) : Prop := sorry

def prime (n : Nat) : Prop := sorry

def infinitely_many_primes : Prop := sorry

def Fermat_prime (n : Nat) : Prop := sorry

def infinitely_many_Fermat_primes : Prop := sorry

def goldbach_conjecture : Prop := sorry

def Goldbach's_weak_conjecture : Prop := sorry

def Fermat's_last_theorem : Prop := sorry

- 尽可能多地证明存在量词一节列出的等式。

证明策略

在本章中,我们描述了另一种构建证明的方法,即使用策略(tactics)。 一个证明项代表一个数学证明;策略是描述如何建立这样一个证明的命令或指令。你可以在数学证明开始时非正式地说:“为了证明条件的必要性,展开定义,应用前面的定理,并进行简化。”就像这些指令告诉读者如何构建证明一样,策略告诉Lean如何构建证明。它们自然而然地支持增量式的证明书写,在这种写作方式中,你将分解一个证明,并一步步地实现目标。

我们将把由策略序列组成的证明描述为“策略式”证明,以便与我们迄今为止所看到的写证明的方式进行对比,我们将其称为“项式”证明。每种风格都有自己的优点和缺点。例如,策略式证明可能更难读,因为它们要求读者预测或猜测每条指令的结果。但它们一般更短,更容易写。此外,策略提供了一个使用Lean自动化的途径,因为自动化程序本身就是策略。

进入策略模式

从概念上讲,陈述一个定理或引入一个have的声明会产生一个目标,即构造一个具有预期类型的项的目标。例如, 下面创建的目标是构建一个类型为p ∧ q ∧ p的项,条件有常量p q : Prop,hp : p和hq : q。

theorem test (p q : Prop) (hp : p) (hq : q) : p ∧ q ∧ p :=

sorry

写成目标如下:

p : Prop, q : Prop, hp : p, hq : q ⊢ p ∧ q ∧ p

事实上,如果你把上面的例子中的“sorry”换成下划线,Lean会报告说,正是这个目标没有得到解决。

通常情况下,你会通过写一个明确的项来满足这样的目标。但在任何需要项的地方,Lean允许我们插入一个by <tactics>块,其中<tactics>是一串命令,用分号或换行符分开。你可以用下面这种方式来证明上面的定理:

theorem test (p q : Prop) (hp : p) (hq : q) : p ∧ q ∧ p :=

by apply And.intro

exact hp

apply And.intro

exact hq

exact hp

我们经常将by关键字放在前一行,并将上面的例子写为

theorem test (p q : Prop) (hp : p) (hq : q) : p ∧ q ∧ p := by

apply And.intro

exact hp

apply And.intro

exact hq

exact hp

apply策略应用于一个表达式,被视为表示一个有零或多个参数的函数。它将结论与当前目标中的表达式统一起来,并为剩余的参数创建新的目标,只要后面的参数不依赖于它们。在上面的例子中,命令apply And.intro产生了两个子目标:

case left

p : Prop,

q : Prop,

hp : p,

hq : q

⊢ p

case right

p : Prop,

q : Prop,

hp : p,

hq : q

⊢ q ∧ p

第一个目标是通过exact hp命令来实现的。exact命令只是apply的一个变体,它表示所给的表达式应该准确地填充目标。在策略证明中使用它很有益,因为它如果失败那么表明出了问题。它也比apply更稳健,因为繁饰器在处理被应用的表达式时,会考虑到目标所预期的类型。然而,在这种情况下,apply也可以很好地工作。

你可以用#print命令查看所产生的证明项。

# theorem test (p q : Prop) (hp : p) (hq : q) : p ∧ q ∧ p := by

# apply And.intro

# exact hp

# apply And.intro

# exact hq

# exact hp

#print test

你可以循序渐进地写一个策略脚本。在VS Code中,你可以通过按Ctrl-Shift-Enter打开一个窗口来显示信息,然后只要光标在策略块中,该窗口就会显示当前的目标。在Emacs中,你可以通过按C-c C-g看到任何一行末尾的目标,或者通过把光标放在最后一个策略的第一个字符之后,看到一个不完整的证明中的剩余目标。如果证明是不完整的,标记by会被装饰成一条红色的斜线,错误信息中包含剩余的目标。

策略命令可以接受复合表达式,而不仅仅是单一标识符。下面是前面证明的一个简短版本。

theorem test (p q : Prop) (hp : p) (hq : q) : p ∧ q ∧ p := by

apply And.intro hp

exact And.intro hq hp

#print test

多个策略应用可以通过用分号连接写在一行中。

theorem test (p q : Prop) (hp : p) (hq : q) : p ∧ q ∧ p := by

apply And.intro hp; exact And.intro hq hp

可能产生多个子目标的策略通常对子目标进行标记。例如,apply And.intro策略将第一个目标标记为left,将第二个目标标记为right。在apply策略的情况下,标签是从And.intro声明中使用的参数名称推断出来的。你可以使用符号case <tag> => <tactics>来结构化你的策略。下面是本章中第一个策略证明的结构化版本。

theorem test (p q : Prop) (hp : p) (hq : q) : p ∧ q ∧ p := by

apply And.intro

case left => exact hp

case right =>

apply And.intro

case left => exact hq

case right => exact hp

使用case标记,你也可以在left之前先解决子目标right:

theorem test (p q : Prop) (hp : p) (hq : q) : p ∧ q ∧ p := by

apply And.intro

case right =>

apply And.intro

case left => exact hq

case right => exact hp

case left => exact hp

注意,Lean将其他目标隐藏在case块内。我们说它“专注”于选定的目标。 此外,如果所选目标在case块的末尾没有完全解决,Lean会标记一个错误。

对于简单的子目标,可能不值得使用其标签来选择一个子目标,但你可能仍然想要结构化证明。Lean还提供了“子弹”符号. <tactics>或· <tactics>。

theorem test (p q : Prop) (hp : p) (hq : q) : p ∧ q ∧ p := by

apply And.intro

. exact hp

. apply And.intro

. exact hq

. exact hp

基本策略

除了apply和exact之外,另一个有用的策略是intro,它引入了一个假设。下面是我们在前一章中证明的命题逻辑中的一个等价性的例子,现在用策略来证明。

example (p q r : Prop) : p ∧ (q ∨ r) ↔ (p ∧ q) ∨ (p ∧ r) := by

apply Iff.intro

. intro h

apply Or.elim (And.right h)

. intro hq

apply Or.inl

apply And.intro

. exact And.left h

. exact hq

. intro hr

apply Or.inr

apply And.intro

. exact And.left h

. exact hr

. intro h

apply Or.elim h

. intro hpq

apply And.intro

. exact And.left hpq

. apply Or.inl

exact And.right hpq

. intro hpr

apply And.intro

. exact And.left hpr

. apply Or.inr

exact And.right hpr

intro命令可以更普遍地用于引入任何类型的变量。

example (α : Type) : α → α := by

intro a

exact a

example (α : Type) : ∀ x : α, x = x := by

intro x

exact Eq.refl x

你可以同时引入好几个变量:

example : ∀ a b c : Nat, a = b → a = c → c = b := by

intro a b c h₁ h₂

exact Eq.trans (Eq.symm h₂) h₁

由于apply策略是一个用于交互式构造函数应用的命令,intro策略是一个用于交互式构造函数抽象的命令(即fun x => e形式的项)。 与lambda抽象符号一样,intro策略允许我们使用隐式的match。

example (α : Type) (p q : α → Prop) : (∃ x, p x ∧ q x) → ∃ x, q x ∧ p x := by

intro ⟨w, hpw, hqw⟩

exact ⟨w, hqw, hpw⟩

就像match表达式一样,你也可以提供多个选项。

example (α : Type) (p q : α → Prop) : (∃ x, p x ∨ q x) → ∃ x, q x ∨ p x := by

intro

| ⟨w, Or.inl h⟩ => exact ⟨w, Or.inr h⟩

| ⟨w, Or.inr h⟩ => exact ⟨w, Or.inl h⟩

intros策略可以在没有任何参数的情况下使用,在这种情况下,它选择名字并尽可能多地引入变量。稍后你会看到一个例子。

assumption策略在当前目标的背景下查看假设,如果有一个与结论相匹配的假设,它就会应用这个假设。

example (x y z w : Nat) (h₁ : x = y) (h₂ : y = z) (h₃ : z = w) : x = w := by

apply Eq.trans h₁

apply Eq.trans h₂

assumption -- applied h₃

若有必要,它会在结论中统一元变量。

example (x y z w : Nat) (h₁ : x = y) (h₂ : y = z) (h₃ : z = w) : x = w := by

apply Eq.trans

assumption -- solves x = ?b with h₁

apply Eq.trans

assumption -- solves y = ?h₂.b with h₂

assumption -- solves z = w with h₃

下面的例子使用intros命令来自动引入三个变量和两个假设:

example : ∀ a b c : Nat, a = b → a = c → c = b := by

intros

apply Eq.trans

apply Eq.symm

assumption

assumption

请注意,由Lean自动生成的名称在默认情况下是不可访问的。其动机是为了确保你的策略证明不依赖于自动生成的名字,并因此而更加强大。然而,你可以使用组合子unhygienic来禁用这一限制。

example : ∀ a b c : Nat, a = b → a = c → c = b := by unhygienic

intros

apply Eq.trans

apply Eq.symm

exact a_2

exact a_1

你也可以使用rename_i策略来重命名你的上下文中最近的不能访问的名字。在下面的例子中,策略rename_i h1 _ h2在你的上下文中重命名了三个假设中的两个。

example : ∀ a b c d : Nat, a = b → a = d → a = c → c = b := by

intros

rename_i h1 _ h2

apply Eq.trans

apply Eq.symm

exact h2

exact h1

rfl策略是exact rfl的语法糖。

example (y : Nat) : (fun x : Nat => 0) y = 0 :=

by rfl

repeat组合子可以多次使用一个策略。

example : ∀ a b c : Nat, a = b → a = c → c = b := by

intros

apply Eq.trans

apply Eq.symm

repeat assumption

另一个有时很有用的策略是还原revert策略,从某种意义上说,它是对intro的逆。

example (x : Nat) : x = x := by

revert x

-- goal is ⊢ ∀ (x : Nat), x = x

intro y

-- goal is y : Nat ⊢ y = y

rfl

将一个假设还原到目标中会产生一个蕴含。

example (x y : Nat) (h : x = y) : y = x := by

revert h

-- goal is x y : Nat ⊢ x = y → y = x

intro h₁

-- goal is x y : ℕ, h₁ : x = y ⊢ y = x

apply Eq.symm

assumption

但是revert更聪明,因为它不仅会还原上下文中的一个元素,还会还原上下文中所有依赖它的后续元素。例如,在上面的例子中,还原x会带来h。

example (x y : Nat) (h : x = y) : y = x := by

revert x

-- goal is y : Nat ⊢ ∀ (x : Nat), x = y → y = x

intros

apply Eq.symm

assumption

你还可以一次性还原多个元素:

example (x y : Nat) (h : x = y) : y = x := by

revert x y

-- goal is ⊢ ∀ (x y : Nat), x = y → y = x

intros

apply Eq.symm

assumption

你只能revert局部环境中的一个元素,也就是一个局部变量或假设。但是你可以使用泛化generalize策略将目标中的任意表达式替换为新的变量。

example : 3 = 3 := by

generalize 3 = x

-- goal is x : Nat ⊢ x = x,

revert x

-- goal is ⊢ ∀ (x : Nat), x = x

intro y

-- goal is y : Nat ⊢ y = y

rfl

上述符号的记忆法是,你通过将3设定为任意变量x来泛化目标。要注意:不是每一个泛化都能保留目标的有效性。这里,generalize用一个无法证明的目标取代了一个可以用rfl证明的目标。

example : 2 + 3 = 5 := by

generalize 3 = x

-- goal is x : Nat ⊢ 2 + x = 5

admit

在这个例子中,admit策略是sorry证明项的类似物。它关闭了当前的目标,产生了通常的警告:使用了sorry。为了保持之前目标的有效性,generalize策略允许我们记录3已经被x所取代的事实。你所需要做的就是提供一个标签,generalize使用它来存储局部上下文中的赋值。

example : 2 + 3 = 5 := by

generalize h : 3 = x

-- goal is x : Nat, h : 3 = x ⊢ 2 + x = 5

rw [← h]

这里rewrite策略,缩写为rw,用h把x用3换了回来。rewrite策略下文将继续讨论。

更多策略

一些额外的策略对于建构和析构命题以及数据很有用。例如,当应用于形式为p ∨ q的目标时,你可以使用apply Or.inl和apply Or.inr等策略。 反之,cases策略可以用来分解一个析取。

example (p q : Prop) : p ∨ q → q ∨ p := by

intro h

cases h with

| inl hp => apply Or.inr; exact hp

| inr hq => apply Or.inl; exact hq

注意,该语法与match表达式中使用的语法相似。新的子目标可以按任何顺序解决。

example (p q : Prop) : p ∨ q → q ∨ p := by

intro h

cases h with

| inr hq => apply Or.inl; exact hq

| inl hp => apply Or.inr; exact hp

你也可以使用一个(非结构化的)cases,而不使用with,并为每个备选情况制定一个策略。

example (p q : Prop) : p ∨ q → q ∨ p := by

intro h

cases h

apply Or.inr

assumption

apply Or.inl

assumption

(非结构化的)cases在你可以用同一个策略来解决子任务时格外有用。

example (p : Prop) : p ∨ p → p := by

intro h

cases h

repeat assumption

你也可以使用组合子tac1 <;> tac2,将tac2应用于策略tac1产生的每个子目标。

example (p : Prop) : p ∨ p → p := by

intro h

cases h <;> assumption

你可以与.符号相结合使用非结构化的cases策略。

example (p q : Prop) : p ∨ q → q ∨ p := by

intro h

cases h

. apply Or.inr

assumption

. apply Or.inl

assumption

example (p q : Prop) : p ∨ q → q ∨ p := by

intro h

cases h

case inr h =>

apply Or.inl

assumption

case inl h =>

apply Or.inr

assumption

example (p q : Prop) : p ∨ q → q ∨ p := by

intro h

cases h

case inr h =>

apply Or.inl

assumption

. apply Or.inr

assumption

cases策略也被用来分解一个析取。

example (p q : Prop) : p ∧ q → q ∧ p := by

intro h

cases h with

| intro hp hq => constructor; exact hq; exact hp

在这个例子中,应用cases策略后只有一个目标,h : p ∧ q被一对假设取代,hp : p和hq : q。constructor策略应用了唯一一个合取构造子And.intro。有了这些策略,上一节的一个例子可以改写如下。

example (p q r : Prop) : p ∧ (q ∨ r) ↔ (p ∧ q) ∨ (p ∧ r) := by

apply Iff.intro

. intro h

cases h with

| intro hp hqr =>

cases hqr

. apply Or.inl; constructor <;> assumption

. apply Or.inr; constructor <;> assumption

. intro h

cases h with

| inl hpq =>

cases hpq with

| intro hp hq => constructor; exact hp; apply Or.inl; exact hq

| inr hpr =>

cases hpr with

| intro hp hr => constructor; exact hp; apply Or.inr; exact hr

你将在归纳类型一章中看到,这些策略是相当通用的。cases策略可以用来分解递归定义类型的任何元素;constructor总是应用递归定义类型的第一个适用构造子。例如,你可以使用cases和constructor与一个存在量词:

example (p q : Nat → Prop) : (∃ x, p x) → ∃ x, p x ∨ q x := by

intro h

cases h with

| intro x px => constructor; apply Or.inl; exact px

在这里,constructor策略将存在性断言的第一个组成部分,即x的值,保留为隐式的。它是由一个元变量表示的,这个元变量以后应该被实例化。在前面的例子中,元变量的正确值是由策略exact px决定的,因为px的类型是p x。如果你想明确指定存在量词的存在者,你可以使用exists策略来代替。

example (p q : Nat → Prop) : (∃ x, p x) → ∃ x, p x ∨ q x := by

intro h

cases h with

| intro x px => exists x; apply Or.inl; exact px

另一个例子:

example (p q : Nat → Prop) : (∃ x, p x ∧ q x) → ∃ x, q x ∧ p x := by

intro h

cases h with

| intro x hpq =>

cases hpq with

| intro hp hq =>

exists x

constructor <;> assumption

这些策略既可以用在命题上,也可以用在数上。在下面的两个例子中,它们被用来定义交换乘法和加法类型组件的函数:

def swap_pair : α × β → β × α := by

intro p

cases p

constructor <;> assumption

def swap_sum : Sum α β → Sum β α := by

intro p

cases p

. apply Sum.inr; assumption

. apply Sum.inl; assumption

在我们为变量选择的名称之前,它们的定义与有关合取和析取的类似命题的证明是相同的。cases策略也会对自然数进行逐情况区分:

除了我们为变量选择的名称外,这些定义与合取和析取的类似命题的证明是相同的。cases策略也会在自然数上区分情况:

open Nat

example (P : Nat → Prop) (h₀ : P 0) (h₁ : ∀ n, P (succ n)) (m : Nat) : P m := by

cases m with

| zero => exact h₀

| succ m' => exact h₁ m'

cases策略伙同induction策略将在归纳类型的策略一节中详述。

contradiction策略搜索当前目标的假设中的矛盾:

example (p q : Prop) : p ∧ ¬ p → q := by

intro h

cases h

contradiction

你也可以在策略块中使用match:

example (p q r : Prop) : p ∧ (q ∨ r) ↔ (p ∧ q) ∨ (p ∧ r) := by

apply Iff.intro

. intro h

match h with

| ⟨_, Or.inl _⟩ => apply Or.inl; constructor <;> assumption

| ⟨_, Or.inr _⟩ => apply Or.inr; constructor <;> assumption

. intro h

match h with

| Or.inl ⟨hp, hq⟩ => constructor; exact hp; apply Or.inl; exact hq

| Or.inr ⟨hp, hr⟩ => constructor; exact hp; apply Or.inr; exact hr

你可以将intro h与match h ...结合起来,然后上例就可以如下地写出:

example (p q r : Prop) : p ∧ (q ∨ r) ↔ (p ∧ q) ∨ (p ∧ r) := by

apply Iff.intro

. intro

| ⟨hp, Or.inl hq⟩ => apply Or.inl; constructor <;> assumption

| ⟨hp, Or.inr hr⟩ => apply Or.inr; constructor <;> assumption

. intro

| Or.inl ⟨hp, hq⟩ => constructor; assumption; apply Or.inl; assumption

| Or.inr ⟨hp, hr⟩ => constructor; assumption; apply Or.inr; assumption

结构化策略证明

策略通常提供了建立证明的有效方法,但一长串指令会掩盖论证的结构。在这一节中,我们将描述一些有助于为策略式证明提供结构的方法,使这种证明更易读,更稳健。

Lean的证明写作语法的一个优点是,它可以混合项式和策略式证明,并在两者之间自由转换。例如,策略apply和exact可以传入任意的项,你可以用have,show等等来写这些项。反之,当写一个任意的Lean项时,你总是可以通过插入一个by块来调用策略模式。下面是一个简易例子:

example (p q r : Prop) : p ∧ (q ∨ r) → (p ∧ q) ∨ (p ∧ r) := by

intro h

exact

have hp : p := h.left

have hqr : q ∨ r := h.right

show (p ∧ q) ∨ (p ∧ r) by

cases hqr with

| inl hq => exact Or.inl ⟨hp, hq⟩

| inr hr => exact Or.inr ⟨hp, hr⟩

更自然一点:

example (p q r : Prop) : p ∧ (q ∨ r) ↔ (p ∧ q) ∨ (p ∧ r) := by

apply Iff.intro

. intro h

cases h.right with

| inl hq => exact Or.inl ⟨h.left, hq⟩

| inr hr => exact Or.inr ⟨h.left, hr⟩

. intro h

cases h with

| inl hpq => exact ⟨hpq.left, Or.inl hpq.right⟩

| inr hpr => exact ⟨hpr.left, Or.inr hpr.right⟩

事实上,有一个show策略,它类似于证明项中的show表达式。它只是简单地声明即将被解决的目标的类型,同时保持策略模式。

example (p q r : Prop) : p ∧ (q ∨ r) ↔ (p ∧ q) ∨ (p ∧ r) := by

apply Iff.intro

. intro h

cases h.right with

| inl hq =>

show (p ∧ q) ∨ (p ∧ r)

exact Or.inl ⟨h.left, hq⟩

| inr hr =>

show (p ∧ q) ∨ (p ∧ r)

exact Or.inr ⟨h.left, hr⟩

. intro h

cases h with

| inl hpq =>

show p ∧ (q ∨ r)

exact ⟨hpq.left, Or.inl hpq.right⟩

| inr hpr =>

show p ∧ (q ∨ r)

exact ⟨hpr.left, Or.inr hpr.right⟩

show策略其实可以被用来重写一些定义等价的目标:

example (n : Nat) : n + 1 = Nat.succ n := by

show Nat.succ n = Nat.succ n

rfl

还有一个have策略,它引入了一个新的子目标,就像写证明项时一样。

example (p q r : Prop) : p ∧ (q ∨ r) → (p ∧ q) ∨ (p ∧ r) := by

intro ⟨hp, hqr⟩

show (p ∧ q) ∨ (p ∧ r)

cases hqr with

| inl hq =>

have hpq : p ∧ q := And.intro hp hq

apply Or.inl

exact hpq

| inr hr =>

have hpr : p ∧ r := And.intro hp hr

apply Or.inr

exact hpr

与证明项一样,你可以省略have策略中的标签,在这种情况下,将使用默认标签this:

example (p q r : Prop) : p ∧ (q ∨ r) → (p ∧ q) ∨ (p ∧ r) := by

intro ⟨hp, hqr⟩

show (p ∧ q) ∨ (p ∧ r)

cases hqr with

| inl hq =>

have : p ∧ q := And.intro hp hq

apply Or.inl

exact this

| inr hr =>

have : p ∧ r := And.intro hp hr

apply Or.inr

exact this

have策略中的类型可以省略,所以你可以写have hp := h.left和have hqr := h.right。 事实上,使用这种符号,你甚至可以省略类型和标签,在这种情况下,新的事实是用标签this引入的。

example (p q r : Prop) : p ∧ (q ∨ r) → (p ∧ q) ∨ (p ∧ r) := by

intro ⟨hp, hqr⟩

cases hqr with

| inl hq =>

have := And.intro hp hq

apply Or.inl; exact this

| inr hr =>

have := And.intro hp hr

apply Or.inr; exact this

Lean还有一个let策略,与have策略类似,但用于引入局部定义而不是辅助事实。它是证明项中let的策略版。

example : ∃ x, x + 2 = 8 := by

let a : Nat := 3 * 2

exists a

rfl

和have一样,你可以通过写let a := 3 * 2来保留类型为隐式。let和have的区别在于,let在上下文中引入了一个局部定义,因此局部声明的定义可以在证明中展开。

我们使用了.来创建嵌套的策略块。 在一个嵌套块中,Lean专注于第一个目标,如果在该块结束时还没有完全解决,就会产生一个错误。这对于表明一个策略所引入的多个子目标的单独证明是有帮助的。符号.是对空格敏感的,并且依靠缩进来检测策略块是否结束。另外,你也可以用大括号和分号来定义策略块。

example (p q r : Prop) : p ∧ (q ∨ r) ↔ (p ∧ q) ∨ (p ∧ r) := by

apply Iff.intro

{ intro h;

cases h.right;

{ show (p ∧ q) ∨ (p ∧ r);

exact Or.inl ⟨h.left, ‹q›⟩ }

{ show (p ∧ q) ∨ (p ∧ r);

exact Or.inr ⟨h.left, ‹r›⟩ } }

{ intro h;

cases h;

{ show p ∧ (q ∨ r);

rename_i hpq;

exact ⟨hpq.left, Or.inl hpq.right⟩ }

{ show p ∧ (q ∨ r);

rename_i hpr;

exact ⟨hpr.left, Or.inr hpr.right⟩ } }

使用缩进来构造证明很有用:每次一个策略留下一个以上的子目标时,我们通过将它们封装在块中并缩进来分隔剩下的子目标。因此,如果将定理foo应用于一个目标产生了四个子目标,那么我们就可以期待这样的证明:

apply foo

. <proof of first goal>

. <proof of second goal>

. <proof of third goal>

. <proof of final goal>

或

apply foo

case <tag of first goal> => <proof of first goal>

case <tag of second goal> => <proof of second goal>

case <tag of third goal> => <proof of third goal>

case <tag of final goal> => <proof of final goal>

或

apply foo